ZeM Mitteilungsheft Nr. 22 - Frühjahr 1999

Redaktion: Rettbehr Meier

Editorial

Ich darf mich als neuer Redakteur des Mitteilungsheftes an reichlich

vorhandenem Artikelmaterial erfreuen, und hoffe gleichzeitig, daß

weiterhin so viele umfangreiche Beiträge für das Heft bei mir

eintreffen werden.

Ich agiere als aktiver Redakteur, der die Beiträge kommentiert und auch selbst Artikel oder Abhandlungen beisteuert, dies ist neu für das Mitteilungsheft. Beim Layout orientiere ich mich dagegen am bewährten Vorbild, das von dem früheren Redakteur Dr. Stange-Elbe und seiner Frau Doris Elbe erarbeitet worden ist. Soviel sei zum formalen Teil gesagt. Wir sehen inhaltlich in den Beiträgen dieses Heftes eine gewisse Tendenz widergespiegelt, die weg von Spezialhardware (Stichwort Industrieinstrumente und MIDI) und hin zu Software-Synthese auf gängigen Allzweckrechnern geht. Die inzwischen beachtlichen Taktfrequenzen machen sogar auf preiswerten Rechnern Echtzeitberechnung komplexer Klänge möglich, die wissenschaftlichen/akademischen Konzepte der 60er und 70er Jahre werden nun für jedermann praktikabel. Eine gewisse Hemmschwelle muß dazu vom Musiker freilich überwunden werden, denn ein recht tiefes Verständnis digitaler Signalverarbeitung ist unvermeidliches Rüstzeug, wenn man ohne Frustration und zügig mit diesen Methoden arbeiten will. Rettbehr Meier

↑Das Heft beginnt mit dem sehr umfangreichen Kraftwerk-Artikel. Man mag sich über die musikalische Relevanz dieser Gruppe durchaus streiten, aber die Bedeutung als Trigger zur Beschäftigung mit E.M. für viele Elektroniker ist unbestreitbar. Kraftwerk haben Aufmerksamkeit erregt und somit zweifellos etwas auf dem Gebiet der Musiksoziologie in Bewegung versetzt. Insofern kann ich die Überlänge des Artikels vertreten. (d. Red.)

"Nein eigentlich nicht unbedingt ... die Beach Boys sind eine eigene Kategorie. Wissen Sie, es ist nicht meine Aufgabe, das Image von Kraftwerk zu beschreiben! Es ist immer ziemlich schwer etwas über sich selbst auszusagen. Die Dynamik der Maschinen, die Seele der Maschinen war immer Bestandteil unserer Musik. Trance hat immer etwas mit Wiederholung zu tun, und jeder sucht nach Trance in seinem Leben, usw., beim Sex, in den Gefühlen, beim Vergnügen, bei allem, auf Parties, bei ... Und die Maschinen produzieren eine absolute perfekte Trance." Nur wenigen deutschen Bands der letzten 30 Jahre ist es gelungen, sich einen bleibenden Platz in der Musikgeschichte zu erarbeiten. Zweifelsohne gehören Kraftwerk dazu. Fragt man Musiker aus den verschiedensten Bereichen nach Einflüssen oder Vorbildern, so fällt überraschend oft der Name Kraftwerk. Obwohl sie seit über 10 Jahren keine neuen Stücke veröffentlicht haben, ist ihre Musik in jedermanns Ohr - nicht zuletzt weil sie neben James Brown und Donald Byrd zu den meistgesampelten Künstlern überhaupt gehören. Man kann das Phänomen Kraftwerk allerdings auch von einer zweiten Seite betrachten. In Avantgardekreisen werden Kraftwerk oft nicht ernst genommen. Die allerorten rezitierte Tatsache, daß Kraftwerk die innovative Kraft hinter elektronischer Musik, speziell auch den neueren Auswüchsen wie House oder Techno sei, muß darüberhinaus wesentlich differenzierter betrachtet werden. Auch das Synonym Kraftwerk = technische Innovation, kann nicht ohne weiteres aufrechterhalten werden. Im folgenden Text werde ich eine Brücke zwischen diesen zwei Polen schlagen und folgende Aspekte schwerpunktmäßig behandeln: Wie innovativ war die Musik Kraftwerks zum Zeitpunkt ihrer Entstehung? Welche Bedeutung hatte Technik (Synthesizer, Sequenzer etc.) für die Musik Kraftwerks? Welchen Einfluß hatten und haben Kraftwerk auf das gesamte Spektrum der Musik? Da Kraftwerk sich jedoch nicht allein durch Beschäftigung

mit ihrer Musik erfassen lassen, werde ich auch das private und historische

Umfeld erwähnen, wenn es in Zusammenhang mit den obigen Aspekten steht.

Meine Arbeit ist chronologisch aufgebaut und bietet so auch eine kurze

Biographie der Gruppe.

Phase 1: 1968-1973 Die Anfänge von Kraftwerk liegen in den sechziger Jahren als sich Florian Schneider und Ralf Hütter, in einem Improvisationskurs am Düsseldorfer Konservatorium kennenlernen. Beide verbindet großes Interesse an elektronischer und besonders improvisierter Musik. "Wir wollten zeitgemäße elektronische Musik machen."(Ralf Hütter) Florian Schneider,geboren 1947 am Bodensee, wuchs in den Trümmern Düsseldorfs auf. Er entdeckte die Musique Concrète Pierre Henrys in der Plattensammlung seiner Eltern und war gleichzeitig von der Rockmusik der amerikanischer Radiostationen begeistert. Er lernte Blockflöte, später Querflöte und studierte am Konservatorium Düsseldorf. Seine musikalische Entwicklung beschreibt er folgendermaßen: "Ich hab´ bis zu einem gewissen Punkt ernsthaft studiert, aber dann fand ich es langweilig. Ich war auf der Suche nach etwas anderem, für mich war die Flöte einfach zu limitierend. Bald darauf hab´ ich ein Mikrophon gekauft, dann Lautsprecher, danach ein Echogerät, dann einen Synthesizer. Die Flöte habe ich erst sehr viel später weggeworfen, es war ein Art Entwicklung." "Florian war immer die treibende Kraft, er war sehr innovativ. Wenn es darum ging, neue Entwicklungen einzuleiten, dann war es Florian, der die Dinge vorantrieb. Vom Temperament her war er viel schneller. Wenn es um die zusätzlichen Details innerhalb der Musik ging, dann war das Florians Sache."(Karl Bartos, späteres Mitglied von Kraftwerk) Ralf Hütter wurde 1946 in Krefeld geboren. Er erhält eine

klassische Klavierausbildung und studiert elektrische Orgel am Düsseldorfer

Konservatorium. Trotz des großen Interesses an Musik beschreibt er

seine ersten musikalischen Erinnerungen als Nichts, Stille. Kein Geistesblitz,

kein Ereignis, kein Schock.

Die gesellschaftliche und musikalische Situation und mögliche Einflüsse: Mitte der 60er Jahre schien die Entstehung moderner Musik außerhalb der USA oder Englands unmöglich. Speziell in Deutschland hatte sich die Situation bis ins Absurde gesteigert - sogar ein falscher englischer Akzent wurde genutzt, um sich dem anglophilen Klischee der populären Musik anzupassen. Es existierte keine innovative Musikkultur. Im Rahmen des "Summer of Love "(1967) gingen jedoch die Auflösung gesellschaftlicher Beschränkungen mit dem Bruch der damals strengen Regeln der Pop- und Rockmusik einher. Im Gegensatz zu früheren Experimenten wurden die neuen Vorstöße in Improvisation und Klangerzeugung von einem breiten Publikum akzeptiert und waren somit auch kommerziell verwertbar. Ein gesteigertes politisches Bewußtsein und grundlegende gesellschaftliche Veränderungen hatten immensen Einfluß auf die Kulturlandschaft. Der Ruf nach Identität, aber auch lauter Musik und exzessiven Happenings wurde im noch immer nachkriegsgeschädigten Deutschland lauter. Das neue Bewusstsein spiegelte sich in der Kunst wieder, wo Beuys, Richter oder Kiefer sich bemühten eine deutsche kulturelle Identität aufzubauen. Auch Filmemacher wie Rainer Werner Faßbinder oder Wim Wenders zeigten neue Richtungen auf. Gleichermaßen war die Entwicklung der Musik in Deutschland nicht

zu übersehen. Es war hier eine ungeheure Aufregung und Aufbruchstimmung

zu verzeichnen. Neue Bands entstanden, die einerseits die Musik ihrer amerikanischen

oder englischen Vorbilder weiterentwickelten, sich zunehmend jedoch auch

von ihr abgrenzten. Der Übervater der neuen deutschen elektronischen

Musik war eindeutig Karl-Heinz Stockhausen. Der Begründer der

Darmstädter Schule wird beinah ausnahmslos von allen Formationen,

die in dieser Zeit entstehen, als Inspiration oder Vorbild genannt. Sein

Einfluß geht auch international so weit, daß die Beatles

ihn auf dem Cover ihrer Sgt.-Pepper-LP abbilden. Unter den unzähligen

neuegegründeten Bands sind CAN, Tangerine Dream und

Kraftwerk

die heute noch bekanntesten. Andere Gruppen waren zum Beispiel Amon

Düuel

, Guru Guru oder Faust.

Organisation 1968 entstand der Vorläufer Kraftwerks: Organisation, deren Musik an eine Mischung aus Feedback, Klängen und Rhythmus erinnerte. Von der Form und Inspiration glichen diese ersten Versuche noch stark ihren Kollegen von Can und Amon Düuel. Besonders zwischen Can und Organisation bzw. später Kraftwerk bestanden jedoch große Unterschiede, die in den folgenden Jahren deutlicher wurden. "Kraftwerk waren sehr deutsch. Ich denke mal, daß wir offener waren."(Michael Karoli, Can) "Kraftwerk war die perfekte Antithese von Can und ich finde ihre Musik nicht nur einzigartig, sondern auch unpersönlich, aber das macht ihre humorvolle Komponente wieder wett" (Irmin Schmidt, Can) Organisation nahm 1970 die Platte Tone Float auf. Es wurden konventionelle Instrumente wie Orgel, Flöte, Geige, Baß und Schlagzeug verwendet und die Musik erinnert schwach an die frühen Pink Floyd . Sie wurde jedoch auch als vergleichbar mit vielen anderen Platten aus den Randbezirken von Feedback und Lärm beschrieben. Insgesamt ist die LP wohl wenig richtungsweisend und vermittelt keinesfalls einen Eindruck von der späteren Arbeit Kraftwerks. Florian Schneider und Ralf Hütter haben denn auch nie wieder eine Platte auf reine Improvisation gegründet. Organisation wurde aufgelöst und Florian und Ralf gründeten Kraftwerk. Ursprünglich ein Duo, arbeiteten sie nahezu konstant als Quartett, wobei die Mitspieler anfangs häufig wechselten und Ralf und Florian den musikalischen als auch ideologischen Kern ausmachten. Der Name entstand übrigens beim scherzhaften Spielen mit ostdeutschen Fußballvereinsnamen (Dynamo Dresden, Lokomotive Leipzig, etc.), welche die beiden sehr amüsierten. In den folgenden Jahren werden die Grundlagen der Einzigartigkeit Kraftwerks gelegt. Ideen und Konzepte werden entwickelt, die nachhaltigen Einfluß auf folgende Generationen haben sollten. Richtungweisende Musik sucht man jedoch vergeblich. Der Mythos Kraftwerk

hält hier nicht was er verspricht. Andere Gruppen waren wesentlich

innovativer, besonders was den Einsatz modernen Equipments betrifft. Es

war vorerst eher die Art und Weise, wie Kraftwerk Musik produzierte

und das Image, das sie schufen, welche nachhaltigen Einfluß haben

sollten.

Musik - Technik - Einfluß So sind Ralf Hütter und Florian Schneider unter den ersten einer neuen Art von Musikern in Deutschland. Aus der intensiven Beschäftigung mit ihrem mehr und mehr elektronischen Instrumenten und dem Einrichten ihres ersten Studios (aus dem später das berühmte Kling-Klang-Studio werden sollte) resultierte eine Mischung aus Musiker und Techniker. Sie beginnen technisch orientiert zu denken und entwickeln eine besondere Beziehung zu ihrem Studio. "Das Studio entstand eigentlich vor der Band. Alles ging auf das Studio zurück, ähnlich einem Mutterschiff." (Ralf Hütter) "Wir spielen das Studio". (Kraftwerk) Die Faszination der Technik und die Verbindung von Musikern und Tontechnikern war eventuell aufgrund der Mentalität in Deutschland besonders ausgeprägt. Technisches Interesse einerseits, andererseits Geduld, die komplizierten Geräte zu beherrschen, waren hier besonders vorhanden. Auch heute noch läßt sich diese These belegen. So wird beispielsweise

ein Großteil der Dance-Musik (auch Euro-Trash genannt),

welche die europäischen Charts beherrscht, in deutschen Studios produziert.

Es ist hier nicht die herausragende Kreativität, sondern die Verbindung

von kreativer Arbeit und Handwerk, welche den Erfolg ausmacht. Der Beginn

dieser Entwicklung läßt sich an Kraftwerk verdeutlichen. Es

ist wichtig zu erwähnen, daß diese Entwicklung nicht von Kraftwerk

initiiert oder alleine getragen wurde. Vielmehr zeichnet sich Kraftwerk

eher dadurch aus, die Idee des eigenen Studios sehr konsequent vertreten

und einen geistigen Überbau geschaffen zu haben. Sie definierten sich

als Musiker neu.

Musik Ihre Musik war bisher noch wenig richtungweisend. Es gab wesentlich

interessantere Gruppen und besonders in Amerika wurde auch die neue Technik

schon stärker eingesetzt. In der Tat kauften Kraftwerk erst

sehr spät ihren ersten Synthesizer.

Image Großes Gewicht bei der Betrachtung von Kraftwerk muß

man ihrem Image beimessen. Sie unterschieden sich in dieser Phase von anderen

deutschen Bands besonders durch ihr deutsches Image, wobei dies auch viel

Kritik und Bedenken hervorrief. Eine Verbindung zu nationalsozialistischem

Gedankengut halte ich jedoch für nicht vorhanden. Der bewußt

gewählte deutsche Name (was damals noch unüblicher war als heute),

sowie die durchweg deutschen Titel ihrer Stücke, sind schlichtweg

Ausdruck einer neuen deutschen kulturellen Identität. Sie arbeiteten

schon damals intensiv an ihrem Image, was im weiteren Verlauf im Detail

behandelt wird.

Summe Richtungweisend waren Kraftwerk also in verschiedener Hinsicht:

Die Grundlagen des Home-Recording wurden gelegt. Die Produktionsmittel

wurden den Musikern zugänglich, was eine komplett veränderte

Art der Produktion zur Folge hatte. Ein neuer Musikertypus, der sich als

Verbindung von Musiker und Tontechniker beschreiben läßt, entsteht.

Er denkt technisch orientiert, hat jedoch in gleichem Maße künstlerische

Fähigkeiten. Die Gruppe verbindet Image und Musik und schafft so ein

künstlerisches Gesamtkonzept, hinter dem die Einzelpersonen zurücktreten.

In den folgenden Jahren entstehen einige Kraftwerk-Alben, die ihre

Entwicklung charakterisieren:

1970: Kraftwerk Die Art der Musik ist schon wesentlich disziplinierter als auf Tone

Float

, und es lassen sich erste Elemente erkennen, die später

den Sound der Gruppe ausmachen. Technisch ist der erste Einsatz elektronischer

Percussions interessant. Florian Schneider hatte schon früh damit

begonnen, selbstkonstruierte Rhythmusmaschinen zu bauen, an denen er konstant

weiterentwickelte. Die industriellen Klänge auf Kraftwerk sind zum

Teil richtungweisend für ihre folgenden Alben, andererseits gleicht

die Musik noch sehr den anderen deutschen Bands. Erste Ansätze zu

einer kraftwerk-typischen Grundmelodie lassen sich jedoch schon erkennen.

1971: Kraftwerk 2 - Technik - Musik Besonders im Rhythmusbereich wird eine weitere Entwicklung vollzogen. Man verzichtet völlig auf konventionelles Schlagzeugspiel und verwendet stattdessen eine Rhythmusmaschine und Echobox. Diese Rhythmusmaschine war im weitesten Sinne Bestandteil einer elektrischen Orgel, wie sie Alleinunterhalter noch heute verwenden. Die Schlagzeugsounds wurden von Kraftwerk durch Einsatz verschiedener Effekte verändert: "1971 hatte Kraftwerk immer noch keinen Schlagzeuger, deshalb habe ich eine billige Rhythmusmaschine gekauft, die etliche Voreinstellungen für bestimmte Tanzrhythmen besaß. Indem wir etliche Klänge durch Bandecho und Filter veränderten, stellten wir die Rhythmus-Tracks für unser zweites Album her. Unser Instrumenten-Klang entstand durch selbstgebastelte Oszillatoren und eine alte Hammond-Orgel, über deren Register wir verschiedene tonale Harmonien herstellten. Um zusätzliche Effekte herstellen zu können, haben wir die Tonbänder mit verschiedenen Geschwindigkeiten abgespielt" (Florian Schneider) Kraftwerk war vermutlich auch die erste Band, die live solche

selbstgebauten Schlagzeugmaschinen einsetzte und sie selbst bediente. Trotz

Verwendung moderner Technik bildeten Ralf Hütters Orgelspiel und Florian

Schneiders Flöte noch immer das Grundgerüst ihrer Musik. Der

Sound war jedoch schon weicher geworden und ähnelte mehr den späteren

typischen Kraftwerk-Alben.

Einfluß Auf Kraftwerk und Kraftwerk 2 sind Elemente vorhanden, die sie eindeutig zu den Erfindern des Industrial- und Electronic-Pop machten. Dennoch wurden sie im Vergleich zu Can und Tangerine Dream weiterhin als zweitklassige Gruppe mit Kultgefolge angesehen. Andererseits genossen sie in gewissen Kreisen schon jetzt erhebliches Ansehen. So schrieb Hervé Picart in der französischen Zeitschrift Best: "Die Gruppe besteht aus zwei nachdenklichen Intellektuellen aus Düsseldorf, Ralf Hütter (Keyboards, Electronics) und Florian Schneider (Flöte, Geige, Keyboards, Electronics). Ihre Musik ist sehr schwungvoll, sehr locker, eine Art lang anhaltender Verzauberung, vergleichbar Terry Riley, die auf den ausgedehnten und zusammengefügten, mannigfaltigen Rhythmen und kreisenden Melodien aufbaut. Anfangs war das Publikum allein schon wegen der Musik überrascht,

doch als dann das Licht ausging und auf einen Bildschirm leuchtende Arabesken

projiziert wurden, war die Faszination perfekt.(...) Kraftwerk sind eine

Avantgarde-Band, die Elektronik in Schönheit verwandelt."

[Die Fortsetzung folgt im nächsten Heft, d. Red.]

↑Die Elektronik und die Informationsverarbeitung schreitet weiter ungebremst voran, in geistig konzeptioneller Richtung geht es dagegen in ruhigerem Tempo weiter, wie dieser kleine Rückblick zeigt. (d. Red.) Kurt Schwitters, Maler, Dichter und Werbegrafiker, wurde am 20.06.1887 in Hannover geboren. Der "Sohn aus gutem Hause", besuchte bis 1914 die Kunstakademie Dresden. Die Erfahrung des 1. Weltkrieges erschüttert zu dieser Zeit überall das Vertrauen in Kaiser, Gott und Vaterland, als Reaktion auf den kollektiven Kriegs-Wahnsinn wird die Unsinns-Provokations-Kunst Dada im Züricher Kabarett Voltaire erfunden. Schwitters - inzwischen Werbegrafiker -greift diese Ideen auf und kreiert 1919 eine Collage, u. a. aus einer Anzeige der Commerzbank, lesbar war jedoch nur noch die Silbe "Merz". Dieses Un-Wort aufgreifend erklärt er sich, ganz im Stile Dadas, zum ersten Merz-Künstler und nennt sich selbst von da an im Freundeskreis Kurt Merz. Es entstehen Merz-Bilder, Collagen, Plastiken und seine Villa wird zum Kunstobjekt, zum Merz-Bau (im Krieg zerstört, heute in Hannover rekonstruiert und zu besichtigen). Als wahrer Multimedia-Künstler und Bürgerschreck verschiebt Schwitters virtuos die Grenze zwischen Sinn und Unsinn. So läßt er in Hannover Plakate mit seinem provokanten Liebesgedicht an Anna Blume anbringen, was sofort zu kontroversen Diskussionen führt. 1933 wird auch die Merz-Kunst von den Nazis als "entartet" gebrandmarkt, Schwitters muß 1937 über Norwegen nach England fliehen, er wird lebend nicht wieder zurückkehren. Die Isolation vom Hannoveraner Publikum ist eine Tragödie für den Künstler. Am 8.1.1948 stirbt Schwitters. Seine letzte Ruhestätte findet er 20 Jahre später in Hannover. Auf seinem Grabstein steht sein Wahlspruch: "Man kann ja nie wissen". Dies alles ist vielleicht doch dem einen oder anderen schon bekannt. Unbekannt war mir dagegen folgendes: Nach zehnjähriger, schrittweiser Annäherung über Laut-Gedichte komponiert Schwitters 1932 die Ur-Sonate. Es entstand also eine regelrechte Sonatenform für auf Ur-Laute reduzierte Sprache. Der erste Satz - ein Rondo - bietet so z.B. vier Hauptthemen. Es ist eine Tonaufnahme (wahrscheinlich Acetat-Direktschnitt) des Werkes von Schwitters selbst gesprochen und gesungen erhalten. Was hat das nun mit progressiver E.M. zu tun? Eine ganze Menge, wie ich meine. Oft wird Musik für einen bestimmten Zweck komponiert oder verwendet, also funktionalisiert, mit der dazu notwendigen Einschränkung eines festgelegten Systemes, eines festgelegten formalen Aufbaus und festgelegter Deutung (Affekte, Trauer, Freude usw.). Ohne diese Festlegungen ist Kommunikation eben nicht möglich. Dies ist ganz klar der Fall z.B. beim Trompetensignal und bei Marschmusik, bei Tanzmusik, bei der Untermalung der Handlung in Opern, bei Film, Funk und Fernsehen, bei Kirchenmusik, bei Musik als reinem gesellschaftlichem Ereignis Schwitters extrahiert dagegen - natürlich dadaistisch augenzwinkernd - den reinen Sound aus der Sprache, der Klang allein ist für ihn entscheidend, mit ihm wird gespielt, ein Sinn dieser Laute ist gar nicht mehr notwendig, es wird ja nicht vorrangig kommuniziert. Schwitters greift damit die beginnende Emanzipation des Geräusches im 20. Jahrhundert und die Befreiung der Musik von ihrer formelhaften Bedeutung und Zweckgebundenheit auf, dies alles lag zu dieser Zeit schon längst in der Luft (z.B. Luigi Russolo's Manifest von 1913 "L'arte di Rumori", also etwa "Die Kunst des Geräusches"). Somit kann die Ur-Sonate als ein früher Vorläufer moderner Musik - genauer der Konkreten Musik und auch der E.M. mit modifizierter Sprache (z.B. K.H. Stockhausens "Gesang der Jünglinge", H. Eimerts "Epitaph") angesehen werden. Neben der nun schon über 100 Jahre andauernden Entwicklung der Elektrophone - also der Hardware - gibt es eben auch auf der gedanklichen Ebene - der Software - eine beachtliche Tradition von mindestens ebenso langer Zeit. Dies wird im allgemeinen wenig beachtet und verdrängt, nur wenige Insider wissen darum. Ich habe Aufnahmen der Ur-Sonate - sowohl im Original als auch in einer modernen Version - als Ausgangspunkt für mein Stück mit dem Arbeitstitel Kurt Schwitters genommen, und die schon verfremdete Sprache der Ur-Sonate wiederum variiert, prozessiert, modifiziert und transformiert, ganz im Sinne der o.g. Beispiele (UA, 11.10.97, Emmendingen). Tonträger davon werden allerdings erst im Verlaufe des Jahres 1999 erhältlich sein.

↑Der Softwareansatz zur digitalen Klangsynthese

ist nicht neu. Als gegen Ende der 60er Jahre solche Konzepte diskutiert

und implementiert wurden, konnte dies zu dieser Zeit nur auf Allzweckrechnern

erfolgen, den exorbitant teuren Main-Frames in den Hochschulrechenzentren.

Klangsynthesesoftware kann in 4 Kategorien unterteilt werden. Eine Kategorie sind Syntheseprogrammiersprachen wie CSound, Pcmusic oder CLM. Hierbei handelt es sich um Programmiersprachen, die auf Musikanwendungen spezialisiert wurden. CLM von Bill Schottstädt baut beispielsweise auf die Programmiersprache Lisp auf. Softwaresynthesizer simulieren Konzepte von Synthesizern (meist subtraktive Synthese). Ein Beispiel hierfür ist Reality mit einer FM-Tonerzeugung, Sampler und dem Konzept eines Yamaha VL1. Utilities für spezielle Syntheseformen sind die dritte Kategorie. Hierzu zählen Programme wie Chaosynth mit Granularsynthese, PhyMod mit Physical Modelling oder SMS zur Resynthese. Generator gehört zur Kategorie von Syntheseprogrammiersystemen. Hierzu zählen ebenfalls die Programme Audio Architekt und Virtual Waves. Bei dieser Kategorie von Klangsynthesesoftware baut sich der User durch Verdrahten einzelner Module einen eigenen Synthesizer auf. Man ist nicht, wie bei Reality, an die Vorgaben des Synthesizervorbilds gebunden und besitzt durch die graphische Benutzeroberfläche ein komfortableres Userinterface als bei CSound. Ähnlich einem Modularsystem werden dem User unterschiedliche Module zur Verfügung gestellt. Hierbei ist man nicht auf eine bestimmte Maximalanzahl von Modulen beschränkt. Da Generator in Echtzeit arbeitet, begrenzt die Geschwindigkeit des Rechners die Modulanzahl. Bei heute üblichen Prozessortaktraten über 300MHz kann man gut einige Minimoogs simulieren. Die Modulbibliothek ist reichhaltig und kann bequem durch Updates aufgerüstet werden. Ein Austausch von Ensembles wird durch das Internet zum Kinderspiel. Da Generator auch Eingangssignale modulieren kann, ist es möglich Simulationen einzelner Effektgeräte zu erstellen. Die Ensembles können durch das Plug-In-Konzept in anderen Programmen (z.B. Cubase) genutzt werden. Hierbei sollte man allerdings die heute noch auftretenden Schwierigkeiten durch den Rechenaufwand der beiden Programme beachten. Außerdem scheinen die Windows Betriebssysteme nicht auf Multitasking-Anwendungen spezialisiert zu sein, was zu häufigen Abstürzen führen kann. Ähnlich dem Ordnerprinzip der Betriebssysteme unterscheidet man in Generator Ensembles, Instruments und Macros. Die unterste Ebene ist das Macro. In ihm lassen sich einzelne Schaltungen unterbringen. Macros können ihrerseits Macros enthalten, was sehr komplexe Netzwerke ermöglicht. Ein Zusammenschluß einzelner Macros kann als Instrument definiert werden. Instruments lassen sich einzelnen Midikanälen zuordnen und sind vergleichbar mit dem Programm eines Synthesizers. Mehrere Instruments ergeben ein Ensemble. Hier lassen sich einzelne Instruments multitimbral spielen, was durch die Verwendung einer Sequenzersoftware und die gleichzeitige Erzeugung mehrerer Klänge enorme Rechnerkapazitäten erfordert. Um sparsamer mit diesen Ressourcen umgehen zu können läßt sich die interne Samplerate stufenweise einstellen. Es ist zwar möglich über die 44.100 Hz hinaus zu gehen. Leider fehlt die 48.000 Hz Auflösung, was zu Kommunikationsschwierigkeiten zwischen Generator und DAT-Geräten oder Adat-Recordern führen kann. Der errechnete Klang wird dem Stereoausgang einer 16 Bit Soundkarte zugeführt. Auch hier offenbart sich eine Schwäche, da die Software mit Ausnahme der Audiowerk 8 keine Multichannel Soundkarten unterstützt. Bei den anderen Karten kann man lediglich einen stereo Aus- und Eingang nutzen. Das Erstellen spezieller Schaltungen erfolgt mittels Drag and Drop auf

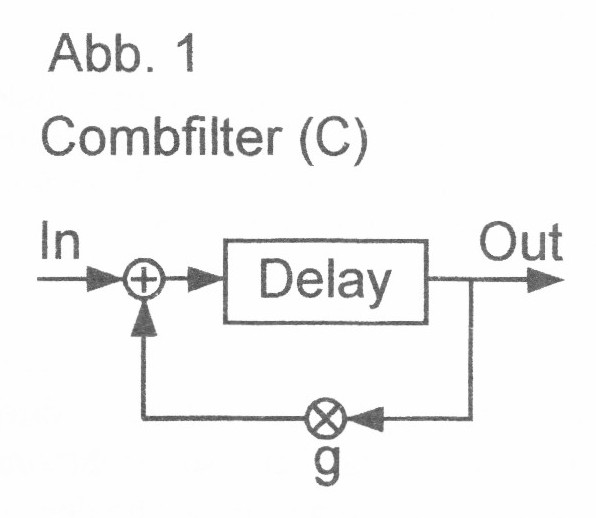

dem Bildschirm. Hierbei zeigt sich Generator sehr flexibel. Als

Beispiel soll ein Combfilter erläutert werden. Als Input wird ein

Impuls benutzt, der in seiner Frequenz und Amplitude steuerbar ist. Hinter

den Impuls wird ein in seiner Verzögerung modulierbares Delay geschaltet.

Der Output wird rückgekoppelt. Das rückgekoppelte Material wird

mit einem Koeffizienten g mit einem Betrag kleiner 1.0 multipliziert, um

eine Dämpfung zu erreichen. (Abb. 1) Mit Modulen wie Audioadder, Modulationdelay, Fader usw. läßt sich diese Schaltung problemlos erstellen. Die Qualität des Klanges und Flexibilität der Steuerung ist ausgezeichnet. Auch hierzu machte ich Experimente mit dem Combfilter. Durch Rückkopplung und Verzögerung im Millisekundenbereich werden Signale addiert, die lediglich in ihrer Phase zueinander verschoben sind. Das Ergebnis sind Frequenzspektren mit Bergen und Tälern, die an die Zacken eines Kammes erinnern. Bei großen Köffizienten (g>=0.9) und Verzögerungen zwischen 1 - 50 ms tritt ein Resonanzeffekt auf. Der Impuls verändert seine Klangfarbe. Ist die Frequenz des Impulses so hoch, daß er selbst als Ton wahrgenommen wird, kann man den resultierenden Klang mit dem Klang einer angezupften Saite vergleichen. Durch die Veränderung der Verzögerung wird die Saite gestimmt. Je kleiner die Verzögerung ist, um so höher klingt die Saite. Interessante Effekte ergibt die Modulation der Verzögerung. Wird das Delay kontinuierlich von 1ms auf 10ms erhöht entsteht ein Klangeindruck, der am ehesten mit dem Glissando bei einer Gitarrensaite verglichen werden kann. Generator bietet auch die Möglichkeit, statt herkömmlicher

Oszillatoren Samples zu benutzen. Hierbei wird eine WAV-Datei in das Modul

importiert. Das Sample kann geloopt und in seiner Frequenz geändert

werden. Klanglich geschieht das selbe wie bei Samplern. Durch Verringern

der Frequenz wird das Sample langsamer ausgelesen. Es klingt tiefer und

langsamer. Wird durch dieses Samplemodul Sprache als Eingangssignal für

den oben beschriebenen Combfilter benutzt, so entstehen vocoderartige Klänge

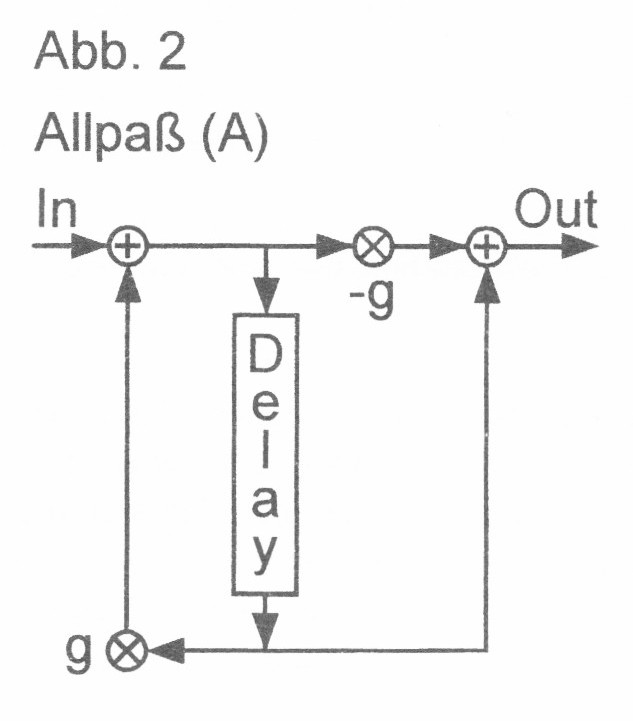

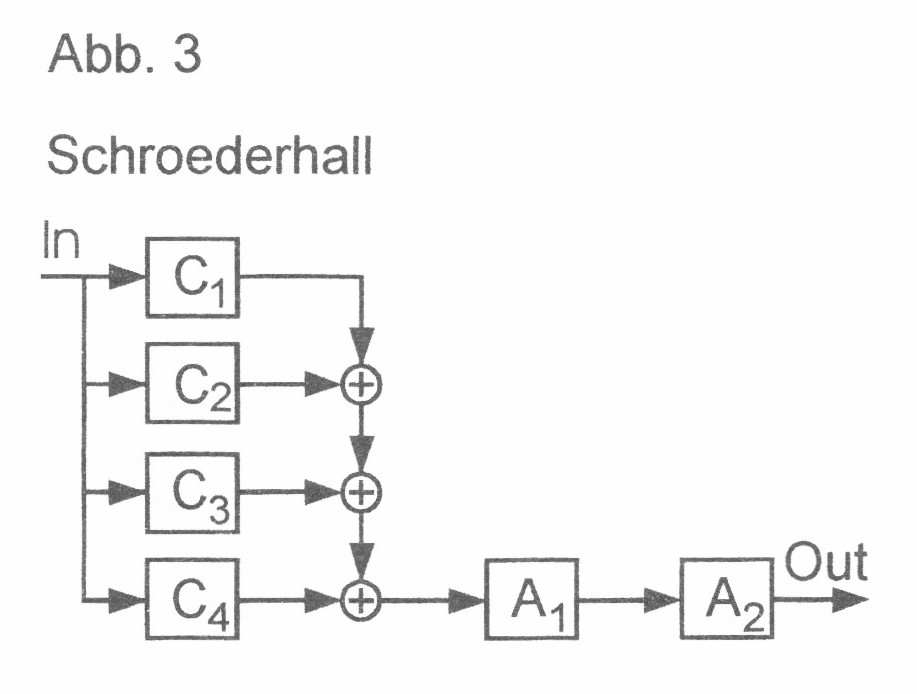

(sprechende Saiten). Ein anderes Instrument, das sich in seinem Klangergebnis kaum von dem Combfilter unterscheidet, ist der Allpaß (Abb. 2). Üblicherweise werden Combfilter parallel und Allpässe seriell geschalten. Das Ergebnis ist ein Schröderhall. Man kann sich leicht vorstellen, daß das Erstellen einer solch komplexen Schaltung sehr unübersichtlich wird. Damit ein solcher Eindruck nicht entsteht, kann man einzelne Schaltungen als Macros zusammenfassen. Einen In- und Output für die Macros bekommt man durch Terminalmodule. Abb. 3 zeigt das Instrument eines Schroederhalls, wobei die einzelnen Combfilter und Allpässe als Macros dargestellt sind. Auch diese Schaltung läßt sich in Generator leicht erstellen.

Eine große Erleichterung ist der Gebrauch eines Hardware-Controllers. Die eingeschleiften Midisignale können mittels einer Thru-Funktion dem nächsten Programm übergeben werden. Somit lassen sich bequem Faderbewegungen durch einen Sequenzer aufzeichnen und automatisieren. Ist der Klang perfekt, läßt man ihn durch den Sequenzer erzeugen, nimmt ihn im Harddisk-Recorder auf und hat anschließend wieder mehr Rechnerkapazität für die nächste Klangspur. Spielt der Rechner mit, hat man mit diesem Softwaresystem eine unabsehbare Zahl an Möglichkeiten. Trotzdem haben Syntheseprogrammiersprachen auch im Zeitalter von Generator noch ihre Berechtigung. In CSound lassen sich beispielsweise If " Then Abfragen einbauen, die in Generator nicht möglich sind. Auch hierzu ein Beispiel. Gewöhnlich wird beim Karplus-Strong-Algorithmus Rauschen als Klanganreger genutzt. Dieses Rauschen wird so lange zu einer Delayline geschickt, bis die einzelnen Zellen des Delays voll sind. Danach wird dieses Signal rückgekoppelt. Dieses ist heute leider noch nicht in Generator umzusetzen. Es gibt noch kein Modul, was einen Schalter bewegt, wenn eine bestimmte Bedingung erfüllt ist. Durch den Echtzeitanspruch ist die Komplexität der Ensembles durch die Rechnerkapazität begrenzt. Bei Syntheseprogrammen braucht man zwar viel Zeit zum Errechnen des Klanges, aber jedes denkbare Netzwerk ist möglich. Bei einem (sehr großen) Netzwerk mit 1000 Sinusoszillatoren, die durch andere Oszillatoren moduliert werden, muß man bei Generator Quellen:

↑

Es geht hier wie in Peter Kiethes Generator-Artikel

um dieselben Fragen, beide Artikel haben als Schnittmenge Aufwand und Freiheitsgrade

bei der Erstellung Elektronischer Musik. Obwohl im folgenden MIDI

und Standard-Hardware kritisiert wird, so benutzt sie jeder weiterhin jeden Tag. Eine

Art von Schizophrenie, die wohl jeder Elektronenmusiker kennt. (d. Red.)

Wenn man verschiedene "aktuelle" Geräte zur Synthese antestet, direkt nebeneinander, etwa bei einer Messe oder beim Händler, so stellt man überraschenderweise fest, daß sich diese klanglich recht wenig unterscheiden, für meinen Geschmack viel zu wenig. Natürlich ist damit nicht das allgegenwärtige "Grand-Piano-Sample" auf Speicherplatz Nr. 1 gemeint. Ich meine hier die "synthetischen" Klänge, also Klänge, die nicht zur Nachahmung irgendeines Vorbildes - sei es nun ein mechanisch-akustisches oder elektrisches Instrument - gedacht sind. Überraschend ist diese Beobachtung in dem Sinne, daß doch

ganz unterschiedliche Syntheseverfahren verwendet werden. Wie kann dies

also sein?

Psychoakustik Man macht diese Erfahrung durch den Gehörsinn, sie fällt damit in den Zuständigkeitsbereich der Psychoakustik. Diese versucht, quantifizierbare Eigenschaften der Übertragungskette akustischer Reiz->Bewußtsein zu ermitteln. Einige wesentliche Ergebnisse dieser Forschungen seien kurz erwähnt: Das Gehör läßt, wie alle Sinne, den größten Teil der Information auf dem Übertragungsweg weg, es findet also eine ganz erhebliche Datenreduktion oder Filterung statt, denn unser Gehirn wäre mit der vollen Informationsmenge völlig überlastet. Eine Konzentration auf das Wesentliche ist notwendig. Das Wesentliche ist durch die Evolution des Menschen festgelegt, und hierbei ist die Sprache ein ganz wesentliches Evolutionsergebnis, also ist das Gehör in irgendeiner Weise für Sprache optimiert. Dies gilt z. B. für die Empfindlichkeit des Gehörs, die dort besonders ausgeprägt ist, wo wichtige Spektralbereiche der Sprache liegen, und für das Verhältnis Silbenrate zur Rate der spektralen Änderungsempfindung, die aufeinander abgestimmt sind, egal um welche Sprache es sich handelt. Spektren werden nicht sehr präzise "analysiert", es kommt sehr viel mehr auf den Verlauf der Spektrumskomponenten in der Zeit an. Als Beispiel mag der Vocoder dienen, der nur ganz entfernt ähnliche Ersatzsignale liefert, die das Ohr aber trotzdem auf Grund ihres zeitlichen spektralen Verlaufes als die ursprüngliche Sprachäußerung verstehen kann. Dies ist ein sehr wichtiger Mechanismus zur Störunterdrückung, ohne den eine Verständigung bei Anwesenheit von Umgebungsstörungen sehr schnell unmöglich würde. Der Verdeckungseffekt führt zur Unempfindlichkeit gegenüber betragsschwachen spektralen Komponenten, diese werden durch lautere in der nächsten Frequenzumgebung zugedeckt. Es gibt noch viele weitere solche Eigenschaften, die in [1] zusammenfassend behandelt werden. Man kann diese Eigenschaften auch sehr gut im Selbstversuch nachvollziehen, es genügt dazu eine Soundkarte, ein Kopfhörer und ein .wav-Editor wie Cool-Edit, mit dem leicht geeignete Signale erzeugt werden können. Ich empfehle eine solche "Selbsterfahrung"! Diese Gegebenheiten machen sich immer wieder bemerkbar, wenn man nämlich mathematisch durchaus ansprechende Syntheseansätze z. B. in C programmiert und dann das akustische Resultat eine gewisse Enttäuschung bietet, oder wenn völlig verschieden aussehende Signalverläufe klanglich ununterscheidbar sind. Es kann also festgestellt werden, daß Klänge im Wesentlichen durch ihren besonderen zeitlich-spektralen Verlauf interessant werden. Es kommt nicht so sehr auf die momentanen Spektren an, die ja je nach Synthesemethode tatsächlich recht unterschiedlich sein können, sondern auf den gesamten Verlauf, also die Makrostruktur, die wir z. B. in einem Spektrogramm beobachten können. Dies alles ist nicht nur akademische Theorie, sondern wird ganz konkret

in Audio-Kompressions-Verfahren wie MPEG oder REAL-Audio

ausgenutzt, um die Datenrate auf das "Allernotwendigste" zu kürzen

(ob das "Allernotwendigste" einer solchen Kompression für jeden Hörer

taugt, ist eine statistische Frage. Wenn 90% der Hörer kein Artefakt

bemerken, haben dann die restlichen 10% einfach Pech gehabt, nicht zur

Mehrheit zu gehören?).

Elektronische Klangverläufe Wie kommt der elektronische Klangverlauf praktisch zustande? In der Pionierzeit der Elektronik gab es nur Regler, die von Hand bedient werden mußten (Trautonium, Ondes Martenot usw.). Dies war sicherlich mühsam, hatte aber den Vorteil, daß man die Parameter der Synthese im schnellen Zugriff gleichzeitig und stetig ändern konnte. Das Trautonium hat heute hierzu im wesentlichen zwei Bandmanuale (Potentiometer), sowie zwei Pedale, die jeweils in 2 Achsen beweglich sind. Es gab zur Entstehungszeit (1930) noch keine Hüllkurvengeneratoren oder ähnliches, das Trautonium bekam erst nach dem Krieg ein solches "Schlagwerk". Das bedeutete, daß die Hüllkurve von Hand erzeugt werden mußte. Wahrscheinlich war der Moog-Synthesizer von 1968 das erste Gerät, das Spannungssteuerung zusammen mit semiautomatischen Hüllkurven einsetzte (ich sage "wahrscheinlich", weil viele kleinere Hersteller unbekannt geblieben sind). Dies war notwendig, wenn man mit einem herkömmlichen Manual auskommen wollte. Seit dieser Zeit und bis heute ist praktisch jedes Instrument mit einer Tastatur oder entsprechendem MIDI-Interface und semiautomatischen Hüllkurven ausgestattet. Dies ist also eine Modellierung der Klangerzeugung, die durchaus mit dem Klavier oder der Orgel vergleichbar ist, wenn man die sich ergebenden Makrostrukturen betrachtet. MIDI ist ganz wesentlich auf eine solche Instrumenten-Struktur ausgerichtet und beschränkt. In der ursprünglichen Konzeption von MIDI bei Sequential sollten sogar nur reine Tasteninformationen übertragen werden. Nur mit dieser Klavier-Orgel-Struktur ist ein kommerzieller Erfolg überhaupt möglich, Instrumentenbauer, die andere Wege gingen, sind heute vergessen, z. B. Donald Buchla, der um dieselbe Zeit wie Moog ebenfalls modulare Systeme baute, allerdings ohne herkömmliche Tastatur. Durch die Verwendung einer Tastatur (oder MIDI) und der Hüllkurven

ist die Makrostruktur der synthetisierten Klänge eingeschränkt.

Die Syntheseparameter können nicht mehr unabhängig voneinander

bewegt werden, sondern sind an die zeitliche An-Aus-Schalter-Charakteristik

der Tastatur gebunden.

Parameterräume Mathematisch kann man das präziser formulieren: Die N Parameter der Synthesemaschine (z. B. Filter-Cutoff, oder Operator-Output-Level) können wir als Koordinaten eines N-dimensionalen Raumes interpretieren, des Parameterraumes. Jeder Punkt in diesem Raum stellt also einen der möglichen statischen Klänge der Synthesemaschine dar. Je nach Auslegung der Kontrolle über die Parameter kann man mehr oder weniger noch alle Punkte des Parameterraumes erreichen, allerdings sind die Wege zwischen diesen Punkten nicht frei wählbar, wenn sie durch semiautomatische Hüllkurven und den Tastaturtrigger festgelegt sind. Die Wege durch den Parameterraum sind jedoch - nach dem bisher

Gesagten - der eigentliche Klang, also das, worauf es ankommt. Das ist

also die Erklärung für die Eingangs festgestellte Beobachtung,

zwar sind die Instrumente intern recht verschieden, sie haben unterschiedliche

Parameterräume

und die einzelnen Punkte der Räume führen zu unterschiedlichen

Spektren, aber die Wege durch diese Klangräume sind nicht sehr verschieden

und gerade diese Information ist für den Gehörsinn sehr wichtig.

Bequemlichkeiten Die Tastatur oder MIDI ist fraglos bequem, und für "normale" Musik durchaus ausreichend. Die Vielfalt der Parameter, der Midi-Daten-Dschungel und die verschiedenen Syntheseformen sind ohnehin für den Durchschnittsmusiker nicht mehr zu verstehen, die andauernde Beliebtheit von Presetinstrumenten belegt dies. Viele kaufen programmierbare Instrumente, spielen dann aber nur die Presets, oder kaufen ROM- oder FLASH-Karten mit anderen Presets. Der Preis für diese Bequemlichkeit ist hoch, nämlich das eingangs erwähnte klangliche Einerlei. Die Klavier-Orgel Struktur hat mehr Einfluß auf den Klang, als alle Parameter zusammen! Wenn alle Instrumente so funktionieren, sind auch die Ergebnisse im Wesentlichen identisch. Als Gegenbeispiel mag noch einmal das Trautonium dienen: Es basiert

auf einer simplen Sägezahnschwingung, die statisch gefiltert und durch

subharmonischeMixturen

erweitert werden kann. Also technologisch nichts besonders Beeindruckendes.

Wenn man sich aber Oskar Sala mit seinem Instrument anhört,

wird man von der Fremdheit dieser Klänge überrascht. Das hat

nicht nur mit Salas Virtuosentum zu tun, sondern mit der Freiheit in der

Gestaltung der (wenigen) Syntheseparameter.

Parameter in der Praxis Noch ein Beispiel aus der Praxis: Mein Yamaha TG77 verfügt über maximal 12 Operatoren "pro Taste", in 45 Algorithmen, mit insgesamt über 1000 Parametern. Die Anzahl der frei steuerbaren Parameter steht dazu in einem geradezu lächerlichen Mißverhältnis: nur eine Handvoll Parameter kann durch MIDI-Velocity oder Modulation in 7-Bit Auflösung verändert werden. Man kann zwar mit Sysex mehr bewegen, allerdings sind zentrale Parameter wie die Operator-Frequenzen in zwei Teile gespalten: Coarse und Fine. Dies läßt erkennen, daß eine freie Steuerung des Parameters Frequenz überhaupt nicht beabsichtigt war. Andere Parameter sind mit der üblichen mageren 7-Bit-Auflösung von MIDI nur mehr schlecht als recht steuerbar, das Gehör reagiert sehr empfindlich auf diese grobe Quantisierung, denn es entstehen unstetige Änderungen anstatt stetiger Verläufe. Man kann also die vielen Parameter einmal einstellen, und dann Tasten drücken aber am Klang nicht mehr viel verändern, das geht stark in Richtung Presetinstrument. Die Vielzahl der Parameter soll und kann wohl diesen Nachteil etwas mildern (z. B. Level-Scaling). Bei meinem Waldorf-Microwave I sieht es etwas besser aus:

4 beliebig zuzuordnende Midi-Controller W, X, Y und Z

können (fast) alle Parameter steuern: Filter-Cutoff und Filter-Resonanz,

Oscillator-A-Volume,

Oscillator-B-Volume,

Wavetablenummer,

Wavenummer.

Die Parameter stimmen mit der 7-Bit-Auflösung von

MIDI überein,

so daß - mit gewissen Einschränkungen - eine Steuerung der Parameter

über die Zeit machbar ist, jedenfalls ergonomischer als beim TG77.

Die Einschränkungen sind ganz klar bei den Oszillatorfrequenzen

sowie bei den sehr groben Volume-Einstellungen der Oszillatoren

zu sehen.

Entwicklungsziele "Ziel der Entwicklung von Synthesemaschinen sollte es sein, dem Musiker möglichst wenige, übersichtliche Parameter, aber trotzdem alle notwendigen, sehr wirkungsvollen Eingriffsmöglichkeiten in die Synthese zugänglich zu machen, die so eine effektive Klangestaltung ermöglichen. Diese Parameter sollten in ihrem Zeit- und Werteverlauf keinen unnötigen Einschränkungen unterworfen sein." Dies ist ein nicht ganz wörtliches Zitat aus [2], und ich halte

dies immer noch für eine sinnvolle Entwurfsvorgabe, bei deren Einhaltung

so etwas wie "innere Schönheit" eines Entwurfs erreicht wird, Ökonomie

und Ergonomie verbinden sich dann von selbst auf wunderbare Weise. Das

Beispiel mit dem TG77 und dem Microwave ist auch in diesem

Zusammenhang illustrativ.

Besondere Anforderungen der E. M. Für die überwiegende Mehrheit der Musiker und der Musik sind die hier diskutierten Einschränkungen überhaupt kein Thema, wahrscheinlich sogar nicht einmal nachvollziehbar, man hat doch was man braucht! Für mich als experimentellen Musiker und für experimentelle E. M. sind diese Einschränkungen immer mehr ein Ärgernis. Kompositionen sind nicht durch das Denkbare begrenzt, sondern durch die willkürlichen und meist noch nicht einmal technisch notwendigen Einschränkungen in der konstruktiven Auslegung der Instrumente. Was überhaupt ist E. M.? Man muß wohl an dieser Stelle diese Frage beantworten. Ich werde hier eine möglichst allgemeine, mathematisch-physikalische Definition Elektronischer Musik versuchen: E. M. geht über die konventionelle Musik hinaus, indem gewöhnliche musikalische Merkmale (z. B. Melodik) auf die freieste Gestaltung verallgemeinerter, elementarer Merkmale, wie der Frequenzen, der Amplituden, der Phasen, der spektralen Strukturen und des zeitlichen Ablaufs dieser Größen hin erweitert werden. Nur die E. M. kann dies tun, indem sie konsequent alle Vorteile elektronischer Synthese-Verfahren ausnutzt und so einen Grad der Freiheit erreicht, der mit konventionellen mechanischen und auch elektromechanischen Musikinstrumenten/Geräten undenkbar ist. Es kommt mir hierbei besonders auf die Worte "freieste Gestaltung" an, ich möchte dies hier ausdrücklich betonen. Es geht nicht um graduelle Verbesserungen, etwa eines neuen Resonanzkastens, eines neuen Pfeifenorgel-Registers, sondern um die denkbar variabelste und freieste Klangestaltung. Es wäre z. B. sehr interessant, den Graubereich zwischen harmonischen und dissonanten spektralen Gestalten bei der FM-Synthese auszuloten, indem in der Entwicklung eines Stückes die Operator-Ratio nach Bedarf um ganzzahlige Verhältnisse herum variiert oder weite Ausflüge macht. Man könnte dies auf der Standard-Hardware (Yamaha) vielleicht erreichen, indem Ereignis für Ereignis einzeln programmiert und aufgenommen wird, also quasi im Einzel-Schuß Verfahren. Nach diesem Prinzip funktionieren die meisten Effekt-Sounds,

die meist ganz hinten in den Presets auftauchen. Nach dem bereits

Gesagten ist es kein Wunder, daß gerade diese Klänge den eigentlichen

Charakter des Instrumentes am besten herausstellen, denn das Einzel-Schuß-Verfahren

benutzt die Tastatur nur als Trigger, alles andere machen komplexe

Hüllkurven (sofern vorhanden), dadurch ist die Makro-Struktur des

Klanges besser von der Klavier-Orgel-Schematik entkoppelt.

Alternativen damals Die Erstellung spezieller Klangverläufe ist mit Standard-Hardware also schwierig bis unmöglich. Wenn man schon digital arbeitet, kann man Klänge aber auch gleich direkt per Software errechnen, etwa mittels C-Sound. Ich ziehe zur Zeit die direkte Umsetzung in einer Allzweck-Programmier-Sprache wie C vor, da es dabei keinerlei Einschränkungen bzgl. der Algorithmen gibt, und mir die Syntax (meine eigene) von C wesentlich besser lesbar erscheint. Ich habe bereits im November erste Produktionen vorgestellt, die in dieser Weise rein durch Software erzeugt wurden. Wie die letzten Workshops, Demonstrationen und Artikel gezeigt haben, werden meine Ansichten in ihrer Konsequenz durchaus von einigen Mitgliedern geteilt. Dies ist alles nichts Neues, seit den späten sechziger Jahren wird an solchen Software-Syntheseprogrammen gearbeitet. Wenn man damals digital arbeiten wollte, war es ja nur so möglich. Z. B. wurde so die Frequenzmodulation an der Stanford University entwickelt. Das war zu dieser Zeit sicherlich kein Vergnügen, da die Berechnungen doch recht lange dauerten. Dafür hatte man die absolute Freiheit. Jeder einzelne Abtastwert konnte speziell behandelt werden. Wenn man sich erst einmal daran gewöhnt hatte, ein akustisches Ereignis im Kopf zu planen, dann mit dem Texteditor zu codieren, dann zu rechnen und zuletzt zu hören, so konnte man schon immer die Vorteile dieser Vorgehensweise genießen: Man kann stets sofort zurückkehren, die "Partitur" ist da, man kann ganz gezielt mit großer Präzision ändern, dies ist eine sehr entspannte Arbeitshaltung, die nichts mit herkömmlichen MIDI-Sequenzing gemein hat. Dieses entspannte Arbeiten ist mir sehr wichtig. Die heterogene Struktur

eines MIDI-Studios macht die Verwaltung sehr schwierig. Wie archiviert

man Sounds, Patches und MIDI-Einstellungen gleichzeitig

und geordnet? Diese Daten gehören für eine Komposition untrennbar

zusammen. Wer kann schon nach ein paar Tagen ein kompliziertes MIDI-Patch

wieder reproduzieren? Vielleicht sind einzelne Sounds nicht mehr

verfügbar, oder schlicht MIDI-Merger und Kanäle verstellt.

Ohne genaue Notizen (auf Papier!) können Arbeiten so nach längerer

Zeit gar nicht wieder aufgenommen werden und lange andauernde Arbeiten

mit Pausenabschnitten werden so zum Suchspiel.

Alternativen heute Ein Wochenkurs am Massachusetts Institute of Technology kostete 1979 um die 900 US $, die Teilnehmer saßen vor grün leuchtenden VT52-Terminals (mit C64 Auflösung) und mußten sich die ohnehin knappe CPU-Zeit teilen [3]. Heute sind die Digitalrechner unglaublich billiger und um mindestens den Faktor 20 schneller zu haben. Was damals nur an Universitäten möglich war, ist heute für jedermann erschwinglich, und gleichzeitig sind die Rechenzeiten so stark zurückgegangen, daß bald eine Klangberechnung in Echtzeit auf jedem Aldi-Rechner möglich sein wird. In diesem Falle wird man noch nicht einmal mehr behaupten können, daß Software-Synthese zu lange dauere. Was die Forschung und die akademische Szene schon seit Jahrzehnten zum Teil unter großen Mühen betrieben hat, kommt nun einfach in jedes Heim. So einfach ist es doch nicht. Denn welcher Musiker ist schon bereit, von den vorgedachten und vorgefertigten Pfaden abzuweichen? Neben der Umstellung der Arbeitsweise benötigt man auch eine gehörige Portion Theorie der digitalen Signalverarbeitung, wenn man denn solcherart an die Wurzeln der Klänge will. Die ersten Versuche sind sonst sehr mühsam, oft wird überhaupt nichts zu hören sein, oder aber Abläufe, die nicht beabsichtigt sind, die man sich nicht erklären kann und die sich scheinbar nicht abstellen lassen. Wer sich nicht auf Software-Synthese einlassen will, könnte sich immerhin durch diesen Artikel zu einer kritischen Bewertung eventueller Neuanschaffungen veranlaßt sehen. Ich würde mir u. a. folgende Fragen stellen:

[1] E. Zwicker, H. Fastl, Psychoacoustics - Facts and Models, Springer Verlag, Second Edition 1999, ISBN 3-540-65063-6 [2] Bernard Hutchins, Hrsg. des Electronotes Newsletter of the Musical Engineering Group (EN), einer Fachpublikation für elektronischen Musikinstrumentenbau, erschienen im Selbstverlag: 1 Pheasant Lane, Ithaca, New York 14850, von 1972 bis heute, EN Mid Month Letter #4, 20.04.77 und #18, 20.06.78 [3] Hal Chamberlin: Course Review - Techniques of Computer Sound Synthesis, EN #103 (9), Juli 1979

↑Es geht um das Problem der

Rezeption von E.M., ein zentrales Problem einer Kunst, die scheinbar den

Kontakt zur Zuhörerschaft verloren hat. Der Vergleich zur modernen

bildenden Kunst wird angestellt, und mir scheint, diese hat der modernen

Musik heute etwas voraus, denn die klassische Moderne ist allgemeinakzeptiert.

Die Vorführungen Elektronischer Musik in der Steinhalle in Emmendingen sind inzwischen schon Tradition geworden. Dennoch haben sie beim Publikum nicht viel bewirkt. Dies führt immer wieder zum Nachdenken nicht nur über die Rezeption Elektronischer Musik in unserer Gesellschaft überhaupt, sondern auch über die Form der Darbietungen: Ist vielleicht das Konzept der "Soundausstellung" doch so ungewohnt, daß es befremdend wirkt, eher abwehrt als anlockt? Da es ja bekanntlich auf den Versuch ankommt, hat ZeM diesen gemacht und die Vorführungen im Herbst 1998 mehr in Richtung "Konzert" gestaltet, zur üblichen Zeit an drei Abenden unter der Woche. Das Experiment war - was den Erfolg angeht - nicht gelungen, dennoch war brachte es ein wichtiges Ergebnis, weil es ZeM darin bestärkt hat, die "Soundausstellung" als Darbietungsform für Elektronische Musik beizubehalten. Zunächst verbindet man den Begriff Ausstellung im Bereich der Kunst mit einer Ausstellung von Objekten der Malerei, der bildenden Kunst. Daß Sound als Objekt in einem Raum präsentiert wird, ist eine neue Form der Darbietung akustischer Ereignisse. Für den Vorführenden ist der Raum nicht nur der Ort der Darbietung, sondern auch die Umgebung für Experimente; für den Hörer ist er nicht nur Ort des ästhetischen Genusses, sondern auch der Ort, der zum Denken und Nachdenken anregen soll. Ein Interview mit dem Kunsthistoriker Jan Hoet, abgedruckt in der Badischen Zeitung vom 8.1.1997, wird durch das Experiment im Herbst 1998 wieder aktuell, denn es zeigt interessante Parallelen zu einer Ausstellung moderner Kunst. Die entscheidende Idee Jan Hoets ist, daß das Museum, der Ort der Ausstellung, ein "Laboratorium" sein soll, ein "Ansatz zum Weiterdenken". Dieses Weiterdenken ist auf die Zukunft ausgerichtet, während der akademische Ansatz [in der bildenden Kunst] die Gegenwart reflektiert und vielleicht aus Angst vor der Zukunft die Zukunft nicht thematisiert. Diese akademische Einstellung und Denkweise hat deshalb auch nicht den Mut, in einer Ausstellung die Objekte radikaler Künstler zu zeigen, sie sucht sich vielmehr die "sicheren" und "bewährten" aus. Das Denken, das in einer solchen Hoetschen Ausstellung initiiert wird, hat als Gegenstand aber nicht das, was war und ist, nicht die Vergangenheit und nicht die Gegenwart, sondern die Zukunft, das, was noch nicht ist, was möglich sein könnte. Die Zukunft ist offen, unsicher und erzeugt deshalb Angst. Es ist deshalb nicht erstaunlich, daß viele sich ihr verschließen und die Sicherheit des Gewohnten suchen. Wendet man sich aber der Zukunft zu, bedeutet das, der Vergangenheit eine radikale Absage erteilen. Diese Überlegungen lassen erkennen, weshalb die Elektronische Musik im Sinne von ZeM nicht auf den großen Erfolg hoffen kann. Denn so wie die Veranstalter von Kunstausstellungen Künstler auswählen, die wenig radikal sind, eher akademisch ausgerichtete Ausstellungen machen, mit denen sie "Kenner und Eingeweihte" ansprechen wollen, mit einem hohen Maß an Ästhetik, so werden in der Regel Veranstalter von Konzerten dem Publikum Elektronische Musik wohldosiert und fein zubereitet, entschärft und mit Ästhetik auf hohem Niveau darbieten. ZeM ist da nicht gefragt. Wenden wir uns aber trotzdem der Zukunft zu und fragen: Was heißt für ZeM Zukunft? Es heißt: neuartige und unerhörte Klänge, experimentelle Sounds in unüblicher Weise produzieren und präsentieren, experimentieren mit der Natur des Klanges, um diese zu entdecken und zu erforschen. Und ZeM wird von Jan Hoet darin bestätigt: das geht nur auf radikale und unakademische Weise. Sich der Zukunft zuwenden heißt aber auch: die fundamentale Bedeutung des Raumes für moderne Kunst erkennen. So ist es nur folgerichtig, daß ZeM ständig auf der Suche nach einem geeigneten Raum ist, auf der Suche nach einem Ort für die Klänge, die für den Raum produziert sind, die nicht an einem beliebigen Ort gehört werden können. Es muß ein Ort sein, der den Klang angemessen zur Geltung bringt; ein Ort, der für Klangexperimente geeignet ist; ein Ort, der das Ambiente für Sounderfahrung bietet; ein Ort, in dem akustisch und ästhetisch die neuen Klänge Raum gewinnen können. Wir suchen weiter, und durch diese Suche werden wir eigentlich nur noch stärker davon überzeugt, daß wir auf dem richtigen Weg sind.

↑Ganz im Sinne des Artikels von Peter Kiethe möchte ich hier kurz ein sehr interessantes Programm zur Granularsynthese besprechen und dabei gleichzeitig die wichtigsten Grundlagen dieser Synthesemethode erklären. GranuLab ist Shareware für Windows von Rasmus Ekman (http://hem.passagen.se/rasmuse/Granny.htm), es ist stabil und sparsam mit Resourcen (läuft mit dem Texteditor während ich diese Zeilen schreibe). Man kann alle Parameter per Maus und MIDI steuern und Audio direkt auf die Festplatte aufzeichnen. Ich habe bereits zwei Stücke mit Granularsynthese erstellt (UA Emmendingen, Herbst 1998)(d. Red) Granularsynthese ist eine der ältesten digitalen Synthesemethoden überhaupt, die Grundidee ist daher notwendigerweise denkbar einfach: Man nehme eine Tonaufnahme oder Sample, zerschneide dies in kurze Schnipsel (Grains), vervielfache diese ggf. und gebe diese Grains nun wieder, indem von Grain zu Grain überblendet wird: einzeln oder gleichzeitig, in dichter Folge oder sporadisch, mit veränderter Geschwindigkeit, lange Grains, sehr kurze Grains, usw. usw, die Variationen sind unendlich. Jeder Erklärungsversuch kann daher unmöglich die klangliche Wirkung beschreiben, starten wir also einfach GranuLab und laden wir mittels File->Load ein .wav-Sample in den Speicher, am besten ein kurzes Sprachsample von einer Sekunde Länge, wir verlieren sonst den Überblick. Playwir hören das Sample unendlich oft wiederholt und probieren nun die langen Schieber aus, von links nach rechts. Der Bereich Soundfile Playback: Mit dem langen Start-Schieber und dem langen Length-Schieber stellen wir den Bearbeitungsbereich des Original-Samples ein, das Fenster. GranuLab erzeugt fortwährend kurze Grains, und zwar bei einem gewissen Ort im Fenster. Dieser Ort bewegt sich automatisch mit einer Geschwindigkeit und Richtung - die mit langem Rate-Schiebervorgegeben ist - durch das Fenster (von 2x bis -2x Originalgeschwindigkeit). Mit Length auf 0 schrumpft das Fenster zu einem Punkt, wir können Ort dann manuell mittels Start bewegen, so entkommen wir dem evtl. störenden Automatismus. Der Bereich Grain Density: Der lange Freq-Schieberbestimmt die Häufigkeit, mit der Grains am Ort erzeugt werden (0.055/s, bis 2005/s.). Vorsicht bei hohen Werten, es kommt zum "Stottern". Keine Sorge: GranuLab stürzt dabei nicht ab, mit ggf. mehrfachem Drücken der Tatstatur-Taste Q könnenwir uns immer retten. Der lange Length-Schieber bestimmt die Länge der einzelnen Grains (von 0.2ms bis 16s), sie reicht also vom Knackser bis zu mehreren Sätzen. Im Bereich Grain Pitch bestimmt der lange Pitch Schieber die Wiedergabegeschwindigkeit der einzelnen Grains. Auf diese Weise ist z.B. extremes Pitch Shifting im Zeitbereich möglich (Faktor 0 (!) bis +-60 Halbtöne). Der Ort kann also durchaus normal vorwärts schreiten, während die Grains, die an diesem Ort erzeugt werden, rückwärts ablaufen! Der lange Gliss-Schieber legt fest, ob die Grain Pitch beim Lauf des Ort über das Fenster von einem festgesetzten Wert auf normal gleitet (+- 48 Halbtöne). Im Bereich Envelope bestimmt der lange Attack Schieber und der lange Decay Schieber die Ein-Ausblende-Zeit der einzelnen Grains (in % der Grain Länge). Dadurch können Rauhigkeiten und Knackser vermieden werden. Zu lange Zeiten verringern natürlich die effektive Laustärke der Grains. Alle kurzen Schieber manipulieren den Parameter ihres zugeordneten langen Schiebers. Die kurzen a-> Schieber legen den prozentualen Einfluß der Amplitude am Ort auf den jeweiligen Parameter fest. Die kurzen RND-Schieber legen den Einfluß einer Zufallsvariablen fest. Der kurze Scale-Schieber ist ein Feinregler für die Rate. Im rechten Patch Bereich kann man mit Shift-Mausklick eine Einstellung in eines der je 20 Patches der 8 Bänke A-H speichern und mit Mausklick wieder abrufen. Der Schieber links neben den Patches legt die Überblendzeit vom aktuellen zum gleich angeklickten Patch fest, das ermöglicht es, viele Regler auf einmal zu kontrollieren und damit von einer Situation in die nächste zu gleiten. Das Gesture Window unter Command->Open Gesture Window ist das Sahnestück des Programmes, es erlaubt ein Überblenden zwischen vier ausgewählten Patches in Joystick-Manier. Dieses 1D und 2D-Überblenden erlaubt eine sehr freie Steuerung der Syntheseparameter auf recht beliebigen Trajektorien und kommt somit meinen Anforderungen (im Artikel "Zurück in die Zukunft, Synthese ohne Beschränkungen" in diesem Heft) sehr nahe. So etwas ist also möglich! GranuLab erzeugt also einen Strom von Grains, der vielfältig und in Echtzeit kontrollierbar ist, man kann u.a. Klänge "gestikulieren". Durch die direkte Aufnahme auf die Festplatte kann man solche Ströme ohne störende Qualitätsverluste festhalten und z.B. hinterher beliebig in einem Audio-Editor nachbearbeiten. Die Kombinationsmöglichkeiten der Parameter und Effekte sind unabsehbar. Extremes Time-Stretching, Pitch-Shifting, Flanging, Chorus, Echo und Amplitudenmodulation sind nur diejenigen, für die ich hier Worte finden kann.

An dieser Stelle folgten in der Printausgabe, wie fast in jeder Ausgabe, ein Antrag auf Mitgliedschaft und die Übersicht der Inhalte der bisherig erschienen Hefte.

Rückseite

|

|

© ZeM e.V. | ZeM Heft Nr. 22 - Frühjahr 1999

|

Die Steuerung der modulierbaren Parameter erfolgt auf der Panelseite.

Hier kann man alle möglichen Parameter durch Softwarefader verändern,

oder Ereignisse anhand von Software-LEDs kontrollieren. Die Parameterbandbreite

ist frei skalierbar. So ist es möglich, einen Softwarefader so einzustellen,

daß er die Frequenz eines Oszillators zwischen 440 " 450 Hz verändert.

Auch die Auflösung ist einstellbar. Da die Softwarefader durch Midi

Inputs kontrolliert werden können, ist die maximale Parameterauflösung

128 Schritte.

Die Steuerung der modulierbaren Parameter erfolgt auf der Panelseite.

Hier kann man alle möglichen Parameter durch Softwarefader verändern,

oder Ereignisse anhand von Software-LEDs kontrollieren. Die Parameterbandbreite

ist frei skalierbar. So ist es möglich, einen Softwarefader so einzustellen,

daß er die Frequenz eines Oszillators zwischen 440 " 450 Hz verändert.

Auch die Auflösung ist einstellbar. Da die Softwarefader durch Midi

Inputs kontrolliert werden können, ist die maximale Parameterauflösung

128 Schritte.