ZeM Mitteilungsheft Nr. 27 - 2006

Redaktion: Rettbehr Meier

EditorialEs ist erstaunlich: bereits 1953 finden wir die ersten veröffentlichten Beispiele Elektronischer Musik, trotz widriger Umstände. Dies ist kein Zufall, sondern Ausdruck einer auch personellen Kontinuität der musikalischen Entwicklung im 20. Jahrhundert. Die E. M. wurde teils mit Unverständnis, teils vehement ablehnend aufgenommen. Fast 54 Jahre später ist die Situation entspannter, es hat sich etwas bewegt, auf natürlichem Wege. Die konservativen Kritiker sterben einfach deswegen aus, weil ein solcher Standpunkt sich schlecht fortsetzen kann. Die Pseudofortschrittlichen dagegen kennen diese ersten Werke nicht und verteidigen vehement ihren Irrtum, dass die jeweils modische populäre Richtung die elektronische Musik repräsentiere. Diese Art von Akzeptanz der elektronischen Klänge ist fast schlimmer noch als deren Ablehnung. Es ist immer wieder nötig, auf die Geschichte zurückzublicken. Das ist kein Kennzeichen einer erinnerungsoptimistischen Nostalgie. Die Zukunft ist unbekannt, die Gegenwart nur ein beliebig kurzer Zeitraum, eigentlich eine Illusion. Wer kein Gedächtnis hat, kann die Gegenwart nicht verstehen. Ohne Erinnerung ist kein Urteil, kein Vergleich, keine Bewertung möglich. Man ist orientierungslos und erfindet das Rad immer wieder neu. Ein weiteres Mitteilungsheft über E. M. liegt hiermit vor. Rettbehr Meier, 21. Dezember 2006

↑Grundsätzlich gibt es zwei Richtungen, Elektronische Musik zu komponieren. Bei der ersten Richtung wird jeder Klang synthetisiert, d. h. jeder Klang wird von Grund auf neu erstellt. Die zweite Richtung geht von "natürlichen" Klängen aus und verfremdet dieses Rohmaterial mit Hilfe elektronischer Geräte. Durch Synthesizer und den Einsatz des Computers zur Klangsynthese werden in der ersten Richtung neue, abstrakte Klangfarben kreiert, die oftmals keine Assoziationen zu mechanischen Instrumenten erzeugen. Diese Klänge kommen in der Natur nicht vor und werden oft als dissonant empfunden. Das Atom dieser Musikrichtung ist der Sinuston. Schon beim Zusammenmischen, also Addieren mehrerer Sinustöne mit unterschiedlicher Frequenz, Amplitude und unterschiedlicher Tonlänge, wird dem Komponist eine unendliche Fülle an Klanglichkeiten eröffnet. Man spricht bei diesem Verfahren von additiver Synthese, vergleichbar mit dem Maler, der seine Farbtöne aus den Primärfarben neu zusammenmischt. Werden statistisch alle vom Menschen hörbaren Frequenzen benutzt, so kann man zum weißen Rauschen gelangen, in Anlehnung an das weiße Licht in der Optik, das alle Farbtöne enthält. Geht ein Komponist von diesem Rauschen aus, kann er mit Hilfe von Filtern unterschiedliche Klangfarben kreieren. Übertragen auf die bildende Kunst könnte man von der Technik einer Radierung sprechen. Dieses Verfahren wird als subtraktive Synthese bezeichnet. Exemplarische Kompositionen für die beiden Verfahren sind Stockhausens Studie I und II. In der Studie I geht Stockhausen vom Sinuston aus und komponiert mittels der additiven Synthese neue Klanggebilde, während in Studie II auch gefiltertes weißes Rauschen zum Einsatz kommt, was der subtraktiven Synthese entspricht. Diese Richtung der Elektronischen Musik wurde zu Beginn der 50er Jahre des 20. Jahrhunderts vom Elektronischen Studio des Westdeutschen Rundfunks in Köln, dessen Leiter damals Herbert Eimert war, vertreten. Im Gegensatz hierzu wird bei der Musique concrète von "natürlichen" Klängen ausgegangen. Vogelstimmen, Wassergeräusche, Schallplatten, aber auch Geräusche des industriellen Umfelds werden als Ausgangsmaterial verwandt. Der Komponist mischt dieses Rohmaterial zusammen, verfremdet es durch den Einsatz diverser Filter und anderer elektronischer Verfahren. Bei dieser Richtung war es grundsätzlich erwünscht, dass der Rezipient Assoziationen zum Klang hatte, was zur Anfangszeit der Elektronischen Musik in Köln nicht beabsichtigt war. Hauptsächlich die GRM in Paris mit seinem damaligen Leiter Pierre Schaeffer, widmete sich dieser Ausrichtung. Bei meiner Komposition Impression 01 wurden fast ausschließlich Klangausschnitte als Ausgangsmaterial verwandt und zwar Musikausschnitte aus Werken impressionistischer Musik. Übertragen auf die Bildende Kunst, kann man dieses Verfahren am ehesten mit der Überarbeitung von bereits vorhandener Kunst, z. B. dem Übermalen von Bildern oder der Collage, vergleichen. Diese Klangausschnitte wurden oft bis zur Unkenntlichkeit verfremdet, durch Transpositionen, Filterungen, Resynthese und Granularsynthese. Diese so erzeugten neuen Klänge wurden in einer zweiten Bearbeitung zusammengemischt, was zu musikalisch höchst komplexen Zusammenhängen führen kann. Mischt man beispielsweise eine Melodiephrase mit der selben Melodiephrase um eine kleine Terz und eine reine Quinte nach oben, bekommt man - musikalisch - ausgedrückt Aneinanderreihungen von Molldreiklängen. Übliche Harmonien der impressionistischen Welt sind die Verwendung des übermäßigen Dreiklangs, oft mit Zusatz einer kleinen oder großen Septime, oder der Gebrauch des übermäßigen Quintsext-Akkordes. Die Klangausschnitte wurden so transponiert, dass beim Zusammenmischen diese Harmonien entstanden. Mittels dieses Mischverfahrens kommt man quasi auf einer Metaebene zu außergewöhnlich komplexen Klanggebilden. Werden darüber hinaus Klangausschnitte, die ihrerseits die für den Impressionismus typischen Harmonien verwenden, auf diese Art abgemischt, kommt man schnell zu den für die Musik des 20. Jahrhunderts typischen Tontrauben. Mischt man die transponierten Klangausschnitte zeitlich versetzt, gerät der Rhythmus aus den Fugen. Echo und Kanoneffekte sind genauso die Folge wie sehr abstrakte Rhythmen. In einer dritten Metaebene wurden die so zusammengestellten Klänge collagenartig auf die 4 Spuren des quadrophonen Raumes verteilt. Das Material wurde teils erneut transponiert, hintereinander gestellt und in Ganztönen auf- oder abwärts transponiert. So kommt es zu der im Impressionismus typischen Verwendung der Ganztonreihe. Ebenso wurde die pentatonische Tonleiter verwandt. Das Klangmaterial wurde so mit Hall- und Echoeffekten abgemischt, dass räumliche Bewegungen und die Verteilung auf einen räumlichen Vorder- und Hintergrund entstanden. Der musikalische Parameter der Klangfarbe ist für impressionistische Musik außerordentlich bedeutend. Ein riesiges Orchester mit ungewöhnlichen Instrumenten und ungewöhnliche Spielweisen der Instrumente, verbunden mit extremen Tonhöhenunterschieden, machen dies deutlich. Kurze Klangtupfer in scheinbar unendlichen Faccetten sind vergleichbar mit der für impressionistische Malerei so typischen Technik des Pointilismus. In Impression 01 wird diese durch das Zerhacken unterschiedlicher Klangflächen auf die Musik übertragen. Bis zu acht Klangflächen wurden zur selben Zeit mit unterschiedlichem Tempo zerhackt. Die resultierenden Klangtupfer sind zeitlich und räumlich verteilt, was zu einem - typisch für impressionistische Musik - flirrenden Musikempfinden führt. Durch die Überarbeitung mit einer Zeitverzögerung wird dieser Effekt zusätzlich verstärkt, tritt jedoch durch den hinzugefügten Hall und die Lautstärkenreduzierung in den Hintergrund. Wie ein roter Faden durchziehen Zitate eines "Gassenhauers" impressionistischer Musik die Komposition. Formal kann sich der Zuhörer an Debussys Clair de Lune orientieren, dass in den oben beschriebenen Verfremdungstechniken das gesamte Stück durchzieht. Teils direkt, oft sehr dezent, wird mit den Zitaten des Debussyschen Klavierstücks gespielt, bis gegen Ende auch der Schluß dieses Stücks in fast unveränderter Form aufgegriffen wird. Auch hier drängt sich ein Vergleich mit der Bildenden Kunst auf. Wird ein Gemälde zum Überarbeiten von einem Künstler verwendet, ist es meist langweilig alle Details des Originals zu übermalen. Der Künstler spielt mit dem dezenten Verändern von Nuancen, bis zum unkenntlich machen des Originals. In Impression 01 reicht die Bandbreite der veränderten Zitate von nuanciert bis zur Unkenntlichkeit. Es wird mit der Bekanntheit des Stückes gespielt, Hörerwartungen aufgebaut und teils erfüllt, oft jedoch durchbrochen. Bei der DTS-Mehrkanalton Variante gibt es eine extreme Dynamik. Um bei sehr leisen Passagen alle Details wahrnehmen zu können, muß das Stück entsprechend laut gestellt werden. Entsprechend werden sehr laute Passagen vom Zuhörer möglicherweise als schockierend empfunden. Plötzliche Wechsel der Dynamik können den Hörer erschrecken, was durchaus erwünscht ist.

↑

Seit etwa 1970 sind elektronische Musikinstrumente oder Musikgeräte im Musikalienhandel für den Endverbraucher

erhältlich und stellen ein ständig wachsendes Marktsegment. Damit einher geht eine Werbepropaganda nicht

unähnlich derjenigen, wie wir sie von Waschmitteln oder Zahnpasta her kennen. Dabei stellt sich die Frage, ob

alles, was uns da als Neuheit verkauft werden soll, auch wirklich so neu ist.

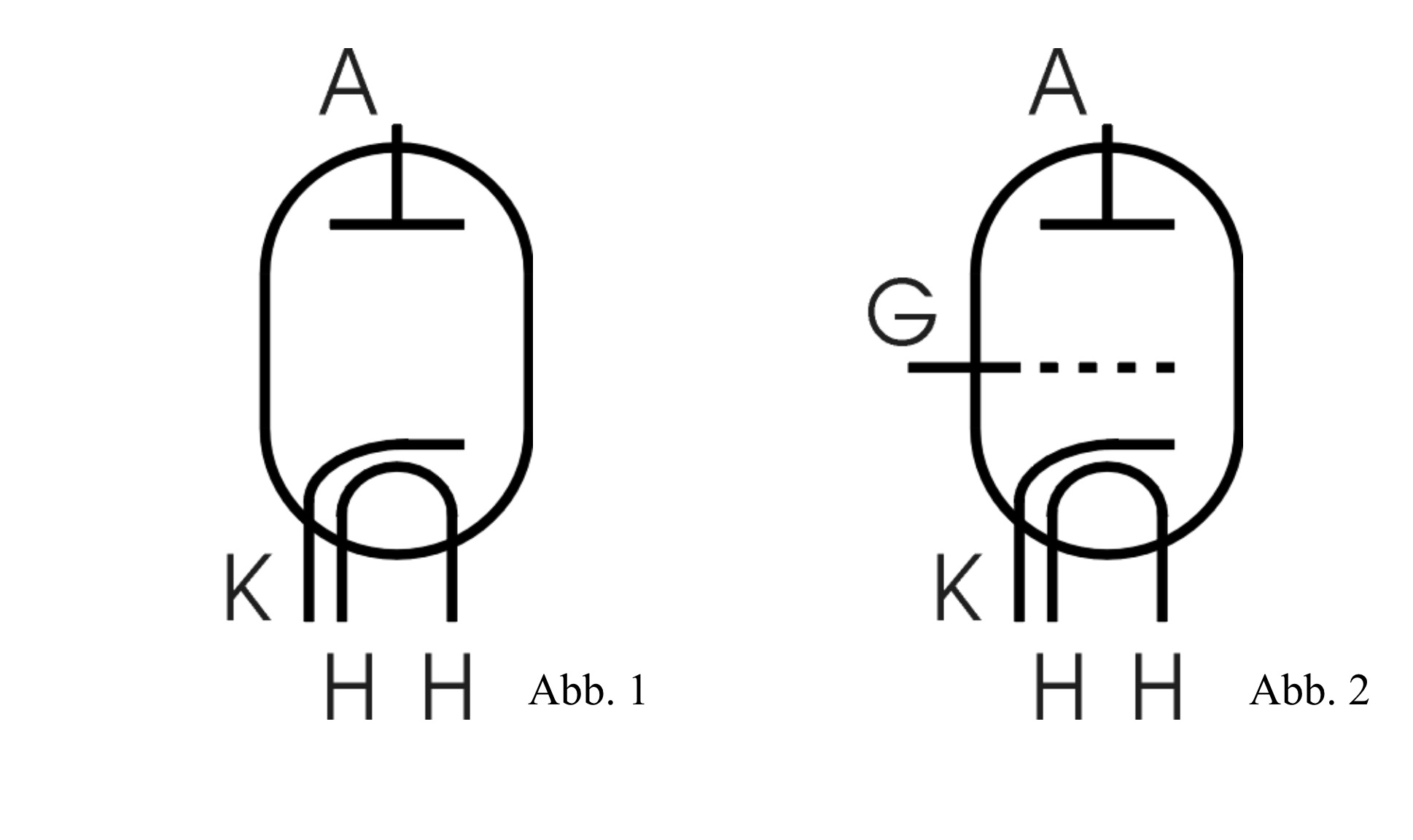

Die Erfindung der Elektronenröhre um 1906 markiert den Eintritt in das elektronische Zeitalter. Es ist eine kuriose Abfolge von Beinahetreffern, viele waren dicht davor, erkannten aber das Wesentliche nicht. Man muß dabei aber anmerken, daß bis zu Einsteins Arbeit zur Brownschen Bewegung 1905 selbst die Existenz von Molekülen und damit auch von Atomen immer noch sehr umstritten war. Edison erkennt schon 1883, daß Strom durch das Vakuum fließt. Er kann sich dies nicht erklären, hat keine Verwendung für sein Patent und so gerät die Sache wieder in Vergessenheit. 1904 meldet der Physiker Flemming seine Röhrendiode zum Patent an (Abb. 1). Man kann daran das Prinzip gut erkennen: in einem Vakuumgefäß aus Glas wird die Heizwendel mit den Anschlüssen H-H mit Strom beaufschlagt, typisch 6.3 V mit 0.3 A. Diese Heizleistung von immerhin fast 2 Watt bringt die Wendel auf 800 ... 900 Grad und damit auch die Kathode K zur Rotglut. Durch die thermische Energie vergrößert sich die Elektronenwolke um die Kathode erheblich. Wenn nun an die Anode A eine gegenüber der Kathode positive Spannung gelegt wird - typisch 100 ... 500 V - , so können aus dieser Wolke Elektronen zur Anode fliegen, es fließt also ein Elektronenstrom durch das Vakuum. Ist die Anode dagegen negativ geladen, so stößt sie die Elektronen zurück. Die Anode ist kalt und kann daher praktisch keine Elektronen aussenden. Die Diode kann also nur Strom in einer Richtung leiten, es ergibt sich eine Ventilwirkung. 1907 meldet De Forest sein Patent an [1], aber dieses behandelt auch immer noch gasgefüllte Röhren. Gleichzeitig reicht von Lieben ein Patent dazu ein. Er setzt auf magnetische, De Forest auf elektrostatische Steuerung. Weder De Forest noch von Lieben wußten zu diesem Zeitpunkt wirklich, wieso ihre Erfindungen funktionierten (Abb. 2). Es wird gegenüber der Diode eine zusätzliche Elektrode G eingeführt - das Gitter. So wird die Diode zur Triode. Die Anode wird gegenüber der Kathode positiv vorgespannt. Das Gitter wird zunächst gegenüber der Kathode negativ vorgespannt. Dies stößt die Elektronen zurück, sie können nicht zur Anode fliegen. Wird die negative Gitterspannung verringert, so können immer mehr Elektronen zur Anode kommen. Dabei darf die Gitterspannung nicht zu groß werden, oder gar positiv, weil dann der üblicherweise sehr geringe Gitterstrom stark anwächst, das Gitter wird zu einer weiteren Anode. Dies kann die feinen Gitterdrähte zerstören.

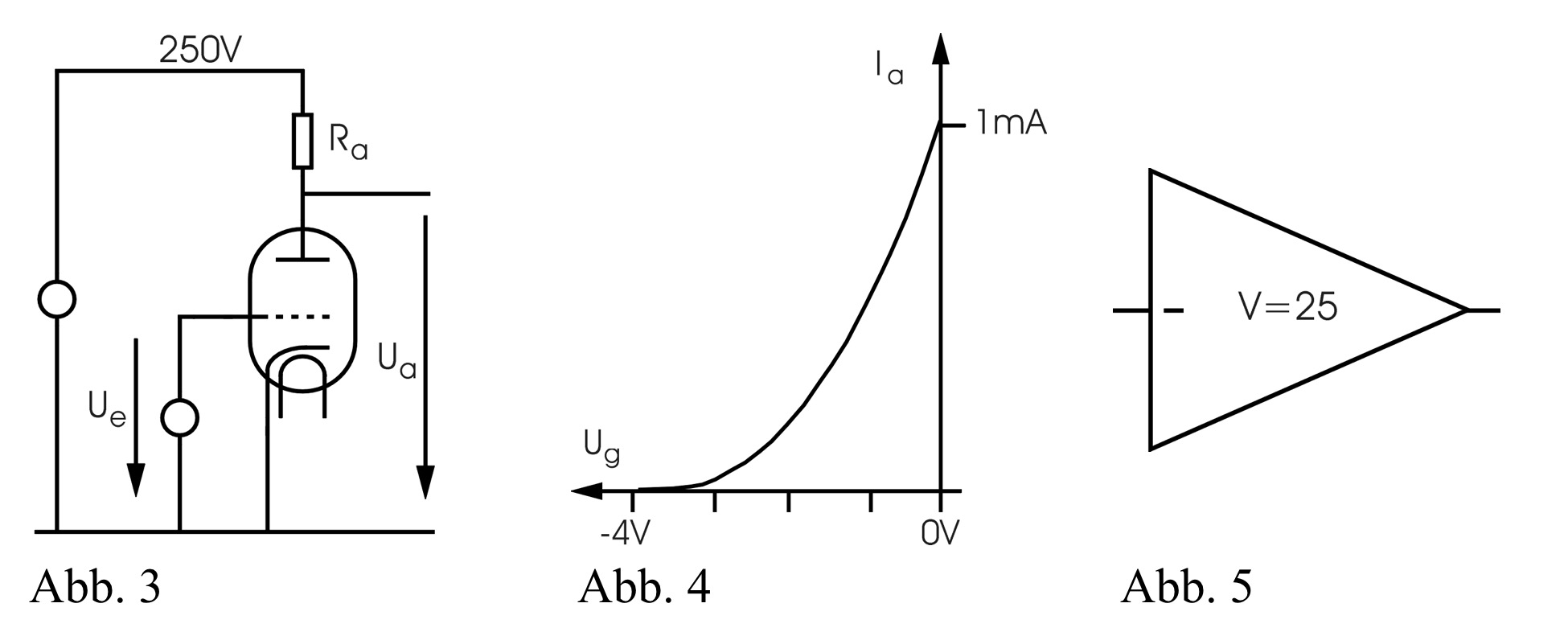

Es ist immer wieder eine ernüchternde Feststellung, daß nur der Krieg die Forschung zu Höchstleistungen vorantreibt. 1915 tauchen in verschiedenen Ländern die ersten wirklichen Hochvakuumröhren auf, durch militärische Geheimhaltung wird der Ablauf der Ereignisse schwer nachvollziehbar. Nach dem Krieg wurde von Lieben die Priorität im deutschen Reich per Gerichtsurteil zugesprochen, dieses Urteil ist - nach allem was wir heute wissen - ein Fehlurteil. Die Machtübernahme der Nationalsozialisten in Deutschland hatte in diesem Zusammenhang zwei Verfälschungen zur Folge: zuerst war die Propaganda bemüht, alle nur möglichen Erfindungen "deutschen" Erfindern zuzurechnen, so wurde von Lieben als einziger und wahrer Erfinder plaziert, was sich bis auf den heutigen Tag in manchen Texten auswirkt. Umgekehrt waren während des Krieges tatsächliche deutsche Erfindungen geheim und die Erfinder nach dem Krieg entweder tot, interniert, verschollen oder untergetaucht, so daß sich nun eine Schieflage in umgekehrter Richtung ergibt. Aus Sicht der Anwendung standen zunächst die typischen Schaltungen für Radiosender- und Empfänger im Vordergrund der Entwicklungen. Dies sind z. B. schmalbandige Filter, Sinusoszillatoren mit nur kleiner Abstimmbandbreite und Audioverstärker. Wir wollen als Beispiel einen einfachen Röhrenverstärker betrachten (Abb. 3). Die Kathode wird auf Bezugspotential gelegt, die Anode über den Anodenwiderstand Ra - typisch 100 kΩ - auf z. B. 250 V, den Heizkreis lassen wir zur Vereinfachung weg. Am Gitter wird die Eingangsspannung Ue angelegt, an der Anode erscheint die Ausgangsspannung gegenüber Bezugspotential. Die Abb. 4 zeigt die typische Steuercharakteristik der Triode. Bei einer Gitterspannung von ca. -4 V fließt kein Anodenstrom Ia. Der maximal erlaubte Strom fließt bei etwas unter 0 V. An dem Anodenwiderstand fällt eine Spannung ab. Fließt mehr Anodenstrom, so sinkt deshalb die Ausgangsspannung.

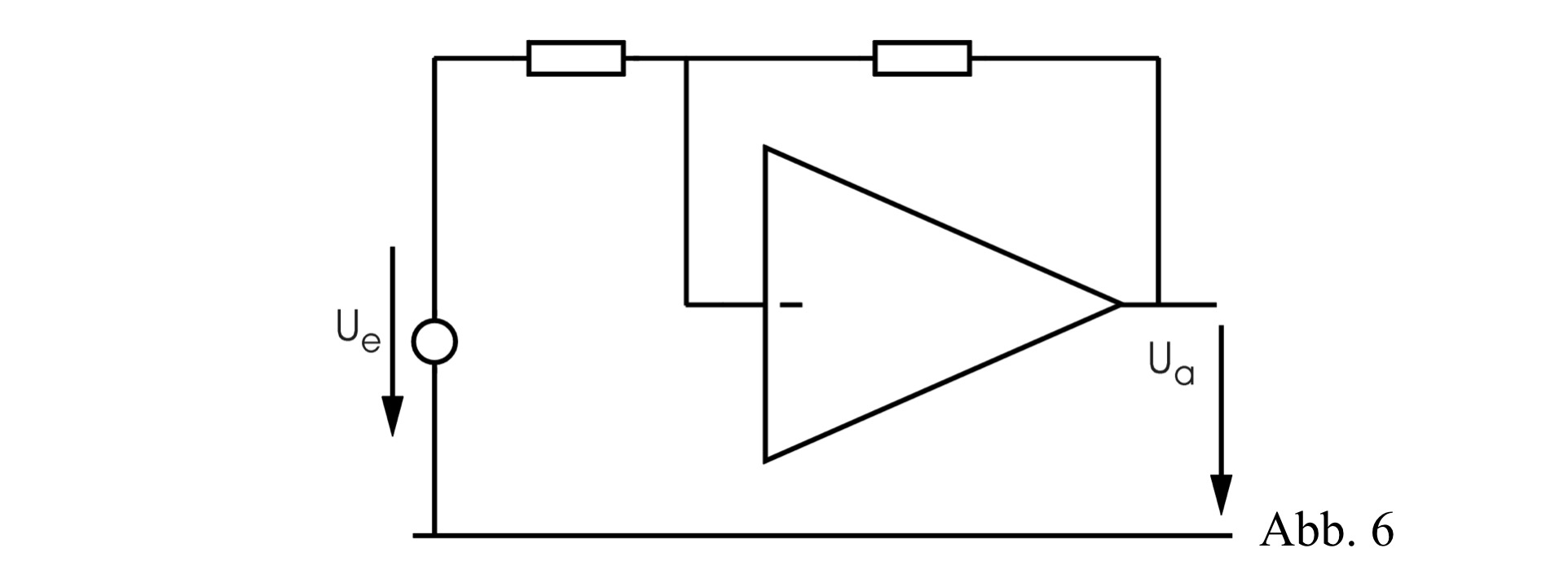

Alle einfachen einstufigen Röhrenverstärker sind deshalb invertierend, steigende Eingangsspannung erzeugt fallende Ausgangsspannung. Eine Variation der Gitterspannung um ca. 4 V ergibt nach Abb. 4 und dem Ohmschen Gesetz eine Ausgangsspannungsänderung um etwa 100 V. Eine einfache Triodenstufe hat also einen Verstärkungsfaktor von ungefähr 25. Die ganze Anordnung wird durch das Verstärkersymbol in Abb. 5 beschrieben. Das Minuszeichen am Eingang deutet an, daß der Verstärker das Signal invertiert. Allerdings kann man die komplette Steuerkurve meist nicht nutzen. Bei näherer Betrachtung von Abb. 4 sieht man, daß der Strom Ia nichtlinear von Ug abhängt. Bei niedrigem Ug ist die Kurve stark gekrümmt, erst bei etwa -1 V wird sie fast linear. Je nach Arbeitspunkt auf der Kennlinie wird der Triodenverstärker also das Eingangssignal verzerren. Da die Krümmung der Kurve um den typischen Arbeitspunkt nur gering ist, werden nur Verzerrungsprodukte zweiter und dritter Ordnung auftreten, die Verzerrung ist daher weich, langsam und stetig mit der Signalamplitude anwachsend und nicht kratzend. Erst mit großen Auslenkungen um den Arbeitspunkt wird die Ausgangskennlinie sehr deformiert und der Klang dann sägend, denn es treten weitere Verzerrungsprodukte höherer ungerader und gerader Ordnung auf. Es fällt außerdem auf, daß der Gleichspannungsanteil an Eingang und Ausgang sehr unterschiedlich ist. Die Eingangsspannung bewegt sich im Bereich -4 ... 0 V, die Ausgangsspannung jedoch zwischen 250 V und 100 V. Deshalb kann man Röhrenstufen nicht direkt ankoppeln, sondern man fügt an Eingang und Ausgang Kondensatoren oder Trenntransformatoren ein, die den Gleichspannungsanteil aus dem Signal entfernen, also einfache Hochpaßfilter (im Beispiel nicht gezeigt). Einfache Röhrenschaltungen sind also als Gleichspannungsverstärker ungeeignet. Später wurden den Trioden zwei weitere Elektroden hinzugefügt, so kommt man zu Pentode. Dabei ist der Ausgangsstrom unabhängiger von der Ausgangsspannung und die erzielbare Verstärkung größer. Die Erforschung der Oszillatoren brachte es mit sich, daß das Phänomen der Rückkopplung genauer untersucht wurde. Der Physiker Heinrich Barkhausen promovierte 1907 über das Problem der Schwingungserzeugung und brachte mehr mathematische Exaktheit in dieses vorher undurchsichtige Gebiet. 1911 erhielt er einen Ruf als erster Lehrstuhlinhaber für Elektrotechnik an das gerade gegründete Institut für Schwachstromtechnik der TU Dresden. Er ging hierbei neue Wege indem die theoretischen, mathematischen Grundlagen und funktionalen Zusammenhänge, also vor allem methodisches Wissen in den Vordergrund rückte. Bisher begnügte man sich mit Tatsachenvermittlung über bereits bestehende Konstruktionen. Allerdings waren zu dieser Zeit die elektrischen Maschinen bei den Studenten beliebter, man wollte lieber Krane und Bahnen konstruieren. Unter Schwachstromtechnik konnte sich niemand etwas vorstellen, man hatte dabei Klingelanlagen und ähnliches Spielzeug im Sinn. So blieb die Studentenanzahl anfangs sehr gering. Barkhausen veröffentlichte die bis heute gültigen Standardwerke über Vakuumröhren in deutscher Sprache [2]. Oszillatoren verfügen immer über eine Rückkopplung vom Ausgang zurück auf den Eingang, denn sie führt dazu, daß stets Energie nachgeliefert wird, um die Schwingung zu erhalten. Im weiteren lernte man, daß die Rückkopplung auch bei Verstärkern nützlich ist. Führt man den Verstärkerausgang mit der richtigen Phasenlage auf den Eingang zurück, so kann man dadurch die Schaltung stabilisieren, man nennt dies dann Gegenkopplung. Die Verstärkung wird kleiner, aber besser definiert und unabhängiger von Variationen der Betriebsspannung oder der Röhren.

Außerdem nimmt auch der Klirrfaktor ab. Je höher die Verstärkung des nichtrückgekoppelten Verstärkers, desto mehr ähnelt diejenige des rückgekoppelten der inversen Übertragungsfunktion des Rückkopplungs-netzwerkes. Ist dieses aus zwei Widerständen aufgebaut, so kann man eine fast ideale Verstärkerwirkung erreichen. In der Abb. 6 ist dies dargestellt. Bei Röhrenschaltungen ist es typisch so, daß jede Röhre eine eigene Gegenkopplung besitzt und dann noch einmal eine über-alles Gegenkopplung vom Ausgang auf den Eingang stattfindet. Zum Prinzip der Gegenkopplung meldeten schon um 1937 verschiedene Erfinder Patente an [3]. Die Eigenschaften der Verstärker werden um diese Zeit also viel besser. Wir kennen die ersten elektronischen Musikinstrumente, die sich den Stand der Technik dieser Zeit zu eigen machten: das Ätherophon, die Ondes Martenot und das Trautonium. Ein elektromechanisches Instrument aus dieser Zeit ist die Orgel von Hammond, auch diese braucht einen Leistungsverstärker und Lautsprecher. Edwin Howard Armstrong war ein US-amerikanischer Ingenieur und Erfinder, der wesentlichen Anteil an Entwicklungen der Kommunikationstechnik hatte. Er entdeckte 1912 das Prinzip der Rückkopplung an der damals brandneuen Triode. Damit konnte er schmalbandig hohe Verstärkungen und Oszillationen erzielen. Schon diese erste Erfindung führte zu einem Patentstreit bis zum obersten Gerichtshof. Durch Armstrongs Sturheit ging der Sieg schließlich 1934 an De Forest. Bei seiner nächsten Erfindung - dem Überlagerungsempfänger - hatte Armstrong einfach Pech. Als er dieses bis heute benutzte Grundprinzip für hochselektive, abstimmbare Radioempfänger anmeldete, war ihm der Franzose Lévy um ein halbes Jahr zuvor gekommen. Carson veröffentlichte schon 1922 seine Untersuchungen zur Frequenzmodulation (FM) und berechnete richtig die bekannten Terme für die Seitenlinien mit den Besselfunktionen erster Art, allerdings schätzte er voreilig ab, daß FM keine Vorteile bei der Nachrichtenübertragung habe [4]. Ab 1927 reichte Armstrong vier FM-Patente ein, denn er erkannte, daß im Gegenteil die Breitband-FM eine störsichere Übertragung von Radiosignalen möglich macht. Diesmal verweigerte das Amt die Patentierung nicht. Armstrong kam jedoch - wie so viele Erfinder - in ernste Schwierigkeiten, weil seine Neuheit bereits bestehende Geschäfte beeinträchtigte, diese waren der Verkauf von Amplitudenmodulationsempfängern und Sendern (AM). Besonders die Firma RCA versuchte alles, um die bessere FM-Technik nicht aufkommen zu lassen, unter anderem durch Einflußnahme auf die US-Funkregulationsbehörde (Federal Communications Commission, FCC), die dem FM-Empfang daraufhin mitten in der ersten Verkaufsphase andere Frequenzbereiche zuwies und bereits bestehende Geräte damit wertlos machte. Die breite kommerzielle Auswertung der Erfindung war damit zunächst gescheitert, aber Polizei und Militär benutzten die Frequenzmodulation weiterhin wegen ihrer Vorteile. Der nächste Krieg brachte noch erheblicheren technischen Fortschritt mit sich. Viele der Arbeiten über Signalanalyse und Signalbearbeitung behandelten militärische Forschungsprobleme. Elektronische Zielverfolgungsgeräte wurden entwickelt, die Treffer auch auf schnell- und tieffliegende Flugzeuge möglich machten. Hierbei muß mit den Daten einer Funkmeßeinrichtung die Position des Zieles bestimmt, die zukünftige Position vorausberechnet und das Geschütz mit diesen Daten ausgerichtet werden. Eine Fülle von Störfaktoren kann hierbei die Ausrichtung verfälschen. Es reicht daher nicht aus, das Geschütz mit elektrischen Antrieben auszurichten, sondern es muß die Ist-Position ständig mit der Soll-Position abgeglichen werden. Es handelt sich also nicht um eine Steuerung, sondern um eine Regelung, wobei die Regelgröße zurückgekoppelt wird. So entfaltete sich die elektronische Regelungstechnik sehr schnell. Deshalb waren bis zum Ende des Krieges grundlegende theoretische Erkenntnisse über Rückkopplungsschaltungen erarbeitet, man findet Namen wie Nyquist, Bode und Blackman, alle bei den Bell Laboratories. Es gab auch auf deutscher Seite weit fortgeschrittene Forschungen dazu. Erste mathematische Arbeiten zur Regelungstechnik findet man schon viel früher, so arbeitete Maxwell 1868 über den Fliehkraftregler von Dampfmaschinen [5] und das Routh-Hurwitz Kriterium zur allgemeinen Stabilität linearer dynamischer Systeme wird auf 1877 datiert [6]. Die Gefahr, daß Regler zu unerwünschten Oszillationen neigen, ist durch das mit den Oszillatoren gemeinsame Element der Rückkopplung unmittelbar erkennbar. Man kann feststellen, daß zum Ende des zweiten Weltkrieges die analoge Signalverarbeitung theoretisch und praktisch voll entwickelt war. Es gab aufwendige Präzisionsrechenschaltungen - wie sie für die Vorhersage einer Flugbahn notwendig sind - und Regelungssysteme mit Rückkopplung, natürlich mit aufwendigen Vakuumröhrenschaltungen. Alles war also schon vorgegeben, als um 1964 Donald Buchla und Robert Moog - der Name Moog wird übrigens gesprochen wie Koog oder Boot - transistorisierte Module auf Basis der analogen Rechentechnik anboten. Eine Neuerung stellte sicherlich die Moog-Kaskade im Jahr 1966 dar [7].

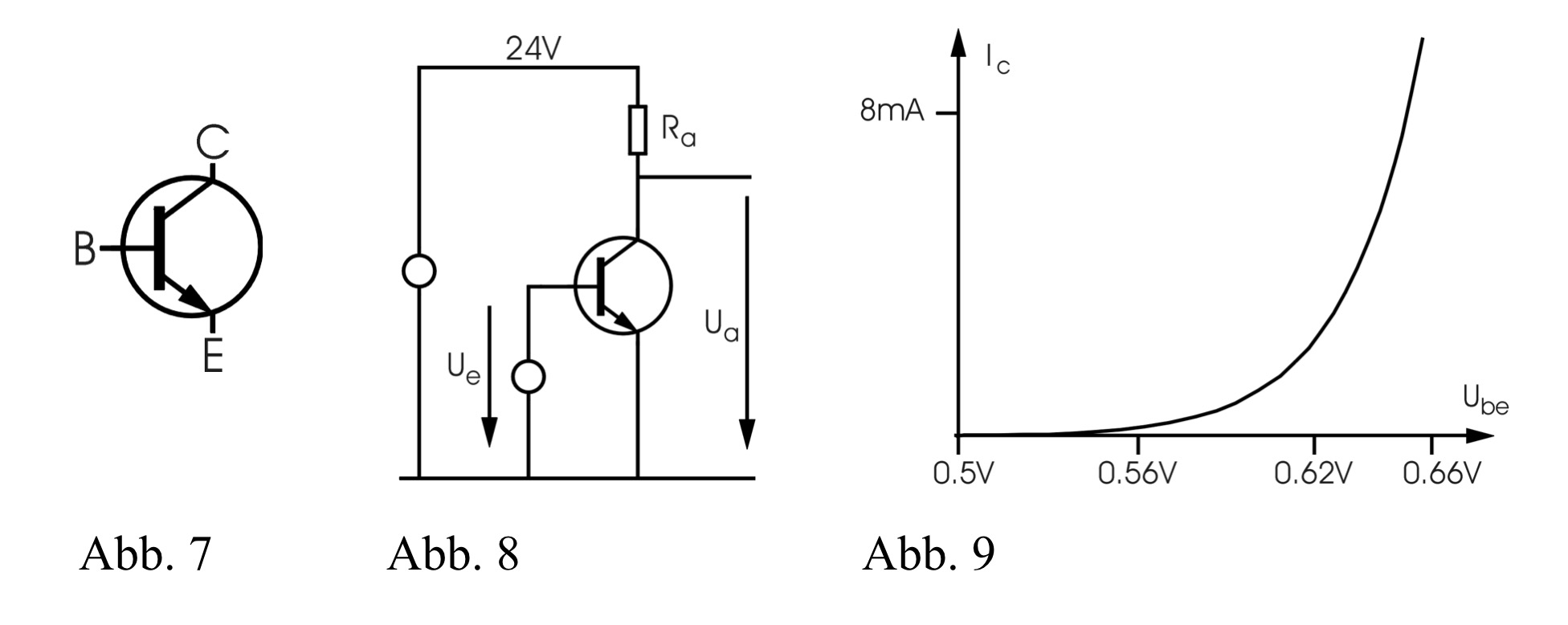

Der Bipolartransistor - um 1947 parallel bei den Bell Laboratories und der französischen Postbehörde PTT entwickelt [8] - hat genau wie die Triode drei Anschlüsse: Emitter, Basis und Kollektor (C) (Abb. 7). Aber anstatt eines Hochvakuumglaskolbens von einigen Zentimeter Größe hat man jetzt ein kleines Halbleiterplättchen von nur wenigen Millimetern. Die Heizung entfällt ganz, so daß in typischen Verstärkerstufen 100 mal weniger Leistung benötigt wird. Die Schaltungen sehen jedoch denen der Röhrentechnik sehr ähnlich, insofern hat sich erstaunlich wenig verändert (Abb. 8). Dabei fällt die um den Faktor 2 bis 100 niedrigere Betriebsspannung auf. Die Steuerkennlinie (Abb. 9) ist völlig anders. Anstatt einer etwas gekrümmten Kurve mit einem fast linearen Teilstück wie bei der Triode tritt nun ein durchweg exponentielles Ansteigen des Stromes auf, also etwas extrem Nichtlineares. Der Transistor liefert typisch etwa 10 mal mehr Strom als die Triode, bei einer sehr kleinen Eingangsspannungsvariation von vielleicht 0.5 ... 0.7 V. Hier nicht zu sehen ist die enorme Temperaturdrift. Anders als bei der Röhre hängt der Ausgangsstrom auch sehr stark von der Temperatur ab, was solch einfache Schaltungen unbrauchbar macht. Man erkennt, daß Transistorschaltungen leicht 10 bis 20 mal mehr Verstärkung als Triodenschaltungen haben. Wegen der Nichtlinearität muß man sich entweder auf sehr kleine Eingangsspannungen beschränken - und bekommt dann Probleme mit Rauschen und Einstreuungen -, oder man wendet die Gegenkopplung in sehr viel weitergehendem Maße an als bei den Röhren. Da ein Transistor sehr viel billiger als eine Röhre ist und sich zudem Dutzende oder Hunderte auf einem Kristall monolithisch integrieren lassen - wir kennen das als Integrierte Schaltung - , so verwendet man in der Transistortechnik typisch sehr viel kompliziertere Schaltungen, die mit vielen Transistoren zum gewünschten Ergebnis führen. Einfache Verstärkerstufen haben typisch 5 Transistoren, nahezu ideale Verstärker baut man mit 50 oder mehr. So lassen sich Verstärkungsfaktoren von 100.000 und darüber erreichen, bei sehr niedriger Drift. Der erhöhte Schaltungsaufwand macht Eingang und Ausgang gleichspannungsfrei, es sind also keine Hochpaßfilter zur Ankopplung notwendig, man kann mit Transistoren preiswerte Gleichspannungsverstärker mit hoher Präzision bauen. Die Unterschiede zwischen Triode und Transistor haben Auswirkungen auf den Klang. Die einfache Triodenstufe hat etwas Verzerrungen, die langsam mit der Signalamplitude ansteigen. Die typische Transistorschaltung mit über-alles Gegenkopplung hat zunächst fast gar keine Verzerrungen, bis schlagartig heftige Signalbegrenzungen einsetzen. Je nach Schaltung kommt es dabei zu symmetrischen Begrenzungen, die Verzerrungsterme ungeradzahliger Ordnung hervorbringen, die einfacheren Schaltungen haben oft auch solche geradzahliger Ordnung. Der Musiker spricht hier ob des scharfen, kratzenden Klanges von der "Transistorsäge". Bei Tongemischen ergibt sich schnell ein undefinierbarer Klangbrei. Die eher sanfte Charakteristik der Triode ist der Grund dafür, daß Musiker bei Verzerrern - wie z. B. in Gitarrenverstärkern - immer noch Vakuumröhren bevorzugen. Kehren wir noch einmal zur FM zurück. Der Ausgang des Krieges hatte interessanterweise Einfluß auf deren Verbreitung. Deutschland war von der Kopenhagener Frequenzkonferenz 1948 ausgeschlossen und es blieben nur die Frequenzbereiche für eine Radioübertragung übrig, die die Teilnehmer der Konferenz damals für nutzlos hielten. Dieser Witz der Geschichte führte dazu, daß sehr schnell das noch heute bestehende FM-Radio mit Trägerfrequenzen von 88...108 MHz eingeführt wurde, was sich vorhersehbar gegenüber der AM-Ausstrahlung auf Mittelwelle als überlegen darstellte. Dieser Frequenzbereich ist übrigens genau derjenige, mit dessen Zuweisung die FCC den Erfinder Armstrong einst schädigte. Im selben Jahr 1948 verklagte dieser die Firmen RCA und NBC wegen Verletzungen seiner Patente. Die durch geschicktes Taktieren der gegnerischen Anwälte sich hinziehenden Verfahren zehrten seine Ersparnisse auf, wirkten psychisch zermürbend und trieben ihn schließlich 1954 in den Freitod. Seine Witwe konnte erst 1967 die Prozeßserie mit dem 21. Verfahren beenden. Insgesamt erhielt sie 10 Mill. US-$ Schadensersatz von den Prozeßgegnern. Durch die inzwischen große Verbreitung war FM Basiswissen jedes Radio- und Funktechnikers. Es ist daher abseits jeder Wahrscheinlichkeit, daß niemand auf der Welt zu diesem Zeitpunkt Experimente mit analoger Frequenzmodulation auch im Audiobereich unternommen haben soll. Zumal analoge Oszillatoren, wie sie in den fünfziger und sechziger Jahren des letzten Jahrhunderts laborüblich waren, eine solche mit sehr einfachen Mitteln erlauben. Der Wobbeloszillator war damals ein Standardwerkzeug und basiert auf einer rampengesteuerten Frequenzmodulation eines Sinusoszillators - auch im Audiobereich. Das Modulsystem M100 von Donald Buchla bot schon 1963 einen Oszillator, der frequenzmodulierbar war. John Chowning von der Stanford University experimentierte um das Jahr 1968 mit extremem Vibrato und entdeckte für sich neu das Phänomen der spektralen Aufspaltung in Seitenlinien um den Träger. Erst viel später wurde ihm klar, daß die Theorie dazu schon mehr als 46 Jahre bekannt war. Diese Umstände haben jahrelang zu einer merkwürdigen Tendenz in den Veröffentlichungen geführt. Denn tatsächlich ordnet sich die Frequenzmodulation unter den allgemeineren Begriff der Phasenmodulation ein. In der Tat werkelt in den meisten "FM-Geräten" ein Phasenmodulations-Algorithmus, so bei der ganzen DX/SY-Yamaha Linie, was sich auch klanglich äußert. Für den Musiker ist dabei wichtig, daß sich die Stärke der Seitenlinien nicht ändert wenn man das Frequenzverhältnis von Träger und Modulator variiert. Genau dies wäre aber bei FM der Fall. Chowning arbeitete an der diskreten Realisierung auf Digitalrechnerbasis, sein Stanfordpatent von 1975 und das darauf folgende Patent vom Lizenznehmer - der Firma Yamaha - von 1977 verknüpften eine damals schon lange bekannte Methode neu mit den Namen Chowning und Yamaha. Die Methode der "FM-Synthese" ist heute aus Systemsicht mehr als 84 Jahre alt. Nicht nur analoge Verfahren wurden im zweiten Weltkrieg entwickelt, sondern auch diskrete (digitale) Signalverarbeitungsanlagen. Ein erstes funktionierendes System war 1943 das SIGSALY Sprachverschlüsselungssystem [9], das basierend auf den Vocodertechniken der Bell Laboratories entwickelt wurde und die Sprachkommunikation allerhöchster Geheimhaltungsstufe mindestens bis zum Ende des zweiten Weltkrieges unentschlüsselbar machte. Der Vocoder-Teil arbeitete analog, jedoch wurden die 10 Signale für die Analysator-Amplituden, sowie das Stimmhaft-Stimmlos- und das Grundfrequenzsignal in 15 Stufen quantisiert (PCM). Dies war zwingend notwendig, weil die darauf folgenden Schritte der arithmetischen Verschlüsselung der Daten präzise und eindeutig erfolgen mußten, da jeder Fehler die Entschlüsselung unmöglich machte. Eine solche Präzision der Berechnung ist mit analogen Mitteln nicht möglich, man geht daher den Weg der ziffernmäßigen Repräsentation von Werten. Das röhrenbasierte Gerät beanspruchte 40 mannshohe 19-Zoll-Schränke, wog 50 Tonnen und verbrauchte 30 kW elektrische Leistung, etwa so viel wie 20 Kochplatten. Gesendet wurde übrigens mit einer FSK-Modulation, ein sinusförmiger Träger wird dabei durch den rechteckförmigen Modulator in der Frequenz getastet. Nach dem Krieg wurde in den USA an diese Entwicklungen angeknüpft. Die Bell Laboratories - heute Lucent Technologies - hatten als Forschungszentrum des US-Telefonmonopolisten AT&T ein Interesse an Vocodern, Sprachsynthese Sprachsteuerung und Sprachkompression, d. h. an der besseren Ausnutzung der vorhandenen Kabelbandbreiten und an neuen Telefondiensten. Princeton University und Massachusetts Institute of Technology (MIT) waren dabei, genau wie der militärische Ableger des MIT, Lincoln Laboratories. Hier sorgte man sich um das "Jüngste-Gericht-Szenario", also die Situation während oder nach einem größeren thermonuklearen Schlagabtausch. Digitale Signalprozessierung (DSP) sollte RADAR-Messungen verbessern und über Schmalbandübertragung die verschlüsselte Weitbereichskommunikation aufrechterhalten. Lawrence Rabiner erinnert sich, daß er schon als Student 1963 mit DSP Berührung kam (zusammengefaßt und übersetzt nach [10]): "Es war vorher nie die Rede von analoger Signalverarbeitung. Nach meiner Promotion über Sprachsynthese war ich bei den Bell Labs fest angestellt. Wichtig war dabei, daß man dort den Forschern bis in die 70er Jahre sehr weitgehende Freiheiten einräumte. Es gab keine drängenden Projekttermine und es war möglich, auch Seitenpfade zu untersuchen. Man konnte so 20 Jahre in die Zukunft blicken. Es stellte sich zunächst nur die Frage, ob man Systeme aus analogen Komponenten bauen, oder mit Hilfe der immer preiswerter werdenden Computer erst einmal simulieren sollte. Man bemerkte dabei, daß die Simulation eines Systems in wesentlich geringerer Zeit aufgebaut werden konnte, als die Implementation entsprechender Spezialschaltungen. Dann kam man darauf, daß die Simulation selbst die Aufgabe ja schon vollständig erledigte und man die Spezialhardware gar nicht mehr brauchte. Die Ablösung der Hardware durch Software ließ die eigentlichen Verfahren besser hervortreten, man begann nun Signalverarbeitung als sehr weites und generelles Gebiet zu sehen. Es spielte keine große Rolle mehr, ob militärische Signalverarbeitung bei den Lincoln Labs oder zivile Techniken anderswo entwickelt wurden, die Algorithmen waren im wesentlichen dieselben. Aus einer anderen Richtung kam die absolute Sensation dieser Jahre: Cooley (IBM) und Tukey (Princeton, Bell) veröffentlichten ihren Ansatz zur schnellen Fourier-Transformation 1965 [11]. Die Idee war zwar nicht neu - sie läßt sich bis hin zu Gauß im Jahr 1805 zurückverfolgen - aber die Computertechnik erlaubte nun, aus der enorm großen Einsparung an Rechenzeit praktischen Nutzen zu ziehen. Es entstanden in der Folge eine Reihe von Algorithmen, die die beschleunigende Wirkung der Transformation bei Echtzeitanwendungen ausnutzten. Wichtig waren die Arbeitsseminare, die heute unter dem Namen Arden House Workshops bekannt sind. In diesem Anwesen in Staat New York kamen seit Mitte der 1960er Jahre die maßgeblichen Experten der digitalen Signalverarbeitung zusammen. Das Komitee enthielt bekannte Namen: Rader, Helms, Kaiser, Stieglitz, Bergland und mich (aus den USA) und später auch Hans Schüßler (aus Deutschland [12]). Das Komitee tagte alle sechs Wochen, von 1967 nahm ich bis zum Ausscheiden 1980 teil, denn es war außerordentlich effektiv. Es definierte das damals neue Gebiet mit seinen Technologien und es bereitete Veröffentlichungen für neue Seminare auf. Die Mitglieder veröffentlichten selbst die wichtigen Grundlagenwerke. Beim ersten Arbeitsseminar waren 30 Teilnehmer aus aller Welt erhofft, sogar 100 kamen, 70 Arbeiten wurden vorgetragen und jede ging in eine neue Richtung. Die analogen Systeme verloren immer mehr ihren Vorbildcharakter. Am Beispiel der Filter wird dies deutlich. Es gibt die Approximationen (nach Bessel, Lagrange, Tschebyscheff, Butterworth und Cauer), die jeweils eine andere Eigenschaft bestmöglich (optimal) realisieren. Bei der Übertragung dieser Entwürfe auf digitale Filter gehen diese optimalen Eigenschaften z. T. wieder verloren. Es ist daher nur konsequent, direkt im zeitdiskreten Bereich nach Optimalfiltern zu suchen, dabei kommen auch Lösungen heraus, die sich von analogen Filtern deutlich unterscheiden. So kam die Sache schnell ins Rollen, die Leute waren verrückt danach, denn die Alternativen waren magere 3% mehr Leistung pro Jahr beim Beibehalten der bisherigen Technik, oder mit DSP an der Mooreschen Beobachtung [13] teilzuhaben, die explosionsartiges, exponentielles Wachstum von Speicherplatz und Rechengeschwindigkeit versprach. Heute ist DSP ein fundamentales und elementares Lehrfach im Ingenieursstudium. Die großen Probleme waren in der Mitte der 1980er Jahre gelöst, auch die Probleme zweiter Ordnung. Der Rest ist dritter oder vierter Ordnung. Ich lese das nicht mehr. Es steht alles in den Standardwerken, die amtlichen Lösungen sind darin vorgegeben". Die grundlegenden Veröffentlichungen sind z. B. [14][15][16][17]. Soweit die Erinnerungen eines Pioniers der digitalen Signalverarbeitung. Die wirklichen Urheber von Erfindungen oder Forschungen sind nicht immer leicht zu bestimmen. Patente werden nicht immer zu Recht erteilt. Gleichzeitig arbeiten oft mehrere Erfinder unabhängig voneinander an demselben Problem. Auch ein zu Recht erteiltes Patent sagt nichts darüber aus, ob der Erfinder überhaupt verstanden hat, worum es dabei wirklich geht, denn Schutzrechte haben mit Wissenschaft nicht notwendig etwas gemein. Seit Edison wurde es für Erfinder immer schwieriger. Die entstehenden Technologiemonopole haben nur ein Interesse an möglichst großen Gewinnen und keinesfalls am technischen Fortschritt oder an Verbesserung. Der verbrauchsarme Ofen ohne Kamin, der Ölfilter der nie verschleißt und auch elektronische Musiktechniken, dies alles wird niedergemacht, wenn es Marktinteressen zuwider läuft. Gerade in der Musikbranche beobachten wir Konzentrationsprozesse. Kleine unabhängige Firmen gehen in Konkurs oder werden von multinationalen Konzernen aufgekauft: Oberheim, Moog, ARP, PPG, Waldorf, Steinberg, Dr. T's, Emagic, Kurzweil, die Liste ließe sich noch verlängern. Nach dem Verkauf setzt Stagnation ein. Die einstigen Unternehmensgründer scheiden frustriert aus. Denn die Entscheidungsprozesse in großen Unternehmen sind so schwerfällig, daß für innovative Konzepte kein Raum mehr ist. Risiken können beim Erklimmen der Karriereleiter nicht in Kauf genommen werden. Ein persönliches Engagement für ein neuartiges Produkt kommt gar nicht erst auf, es geht nur noch um Marktanteile und Geld. Nur ganz selten gibt es den Fall, daß die ernormen Gewinne der Monopolisten es zulassen, einigen wenigen ihrer Angestellten freie Forschung auf der Spielwiese ohne sofortige Gewinnaussicht zu erlauben. Methoden oder Techniken legen oft einen langen und verworrenen Weg zurück. Irgendwann wird ein Gebiet jedoch aufgearbeitet und verstanden. Die Musikelektronik wertet stets Erfindungen und Forschungen aus anderen Bereichen aus - meist der Nachrichtentechnik -, die um Dekaden zurückliegen. Leider muß man feststellen, daß trotzdem sehr oft aus Unwissenheit, Termindruck oder Kostendruck andere Wege beschritten werden, die deutlich schlechtere Resultate zur Folge haben. Die seit langem bekannten, optimalen Problemlösungen sind offenbar noch nicht überall angekommen. Das Neue ist also gar nicht so neu und oft noch nicht einmal auf dem Stand der seit Jahrzehnten bekannten Standardtheorie. Man erkennt, daß DSP historisch aus Bereichen kommt, wo Nichtlinearitäten eher gemieden werden. Denn kaum zu verstehende, kratzende Telefonübertragungen sind ein Ärgernis. Andererseits wurde dargestellt, daß analoge Röhren- und Transistorschaltungen mehr oder weniger zu Verzerrungen neigen, von der magnetischen Tonbandsättigung ganz zu schweigen. Die Klänge, die wir aus Aufnahmen des ältesten Studios in Köln kennen, sind von diesen Verzerrungen geprägt. Besonders interessant scheint der abstimmbare Anzeigeverstärker UBM BN 12121 von Rohde & Schwarz, mit vier Pentoden und eingebauter Rückkopplung. DJs zahlen heute Unsummen für die letzten existierenden Exemplare, ab und zu taucht eines bei eBay auf. Die Musikwissenschaft dokumentiert zwar den Einsatz des Gerätes, kann uns aber nicht sagen, wie es funktioniert und was das Besondere daran ist [18] - vielleicht in einem späteren Artikel dazu mehr. Solche nichtlinearen Möglichkeiten fehlen uns entweder im digitalen Studio, oder die Implementation ist unbrauchbar. Auf die deutlich unterschiedlichen Charakteristiken von übersteuerten Verstärkern wurde schon hingewiesen. Es ist gut möglich, daß die Nichtlinearitäten solcher Geräte durch algebraische Gleichungen zu beschreiben sind. In diesem Fall ist die Übertragung ins digitale nicht so schwer. Man muß allerdings berücksichtigen, daß dabei Frequenzen entstehen, die oberhalb der halben Abtastfrequenz liegen können, das Ergebnis ist heftiger Alias. Man kommt also nicht umhin, die Abtastrate vor solchen Funktionsblöcken deutlich zu erhöhen - durch Interpolation. Danach kann sie mit Filterung wieder erniedrigt werden - durch Dezimation. Auch diese zwei Techniken sind lange bekannt. Richtig interessant wird die Sache aber erst durch Einbeziehen von Rückkopplungsschleifen. Wie oben bei der Rückkopplung angemerkt, entscheidet auch die Phasenlage, ob ein rückgekoppeltes System stabil bleibt, oder instabil wird. Es ist möglich, daß dabei deterministisch chaotisches Verhalten auftritt. In diesem - möglicherweise interessanten - Fall reagiert das System extrem empfindlich auf Veränderungen. Bei der Übertragung vom zeitkontinuierlichen in den zeitdiskreten Bereich treten insbesondere Veränderungen der Phase auf. Nur mit sehr viel Aufwand läßt sich das analoge Verhalten daher abbilden. Wenn das zu modellierende System nicht als algebraische Gleichung, sondern als nichtlineare Differentialgleichung dargestellt werden muß, tritt noch ein viel größeres Problem auf: das der Systemidentifikation. Wie ist die Differentialgleichung und was sind ihre Parameter? Es stellt sich dann schon die Frage, wieso man nicht gleich analoge Schaltungen nachbaut, denn in diesem Falle ist es umgekehrt: das analoge System ist wahrscheinlich kostengünstiger und schneller realisiert als sein rechnerisches Modell. Maurizio Kagel ist ein großer Experimentator, der viel mit der Verschaltung von Geräten arbeitete und dabei auch Rückkopplungen einsetzte [18]. Wichtig dabei war auch die Übersteuerung von Verstärkern. Machen wir es ihm nach und stecken wir neue Kombinationen zusammen. Wir können dazu gerade auch die ältesten Geräte im Studio benutzen. Wir können modifizierte Lautsprecher, Mikrophone und Räume zum Schwingen bringen.

Was macht dieses praktische, rein elektronische Beispiel? Ich greife hier auf standardisierte Symbole zurück, die es auch schon lange gibt. Obwohl eine solche Schaltung manchmal etwas schwierig zu verstehen ist und obwohl sie sensitiv auf Eingangssignale und Reglerstellungen reagiert, so ist das Ergebnis bei hinreichender technischer Ausführung doch nicht zufällig, sondern reproduzierbar. Je mehr man über die einzelnen Bestandteile und ihre Interaktion weiß, desto eher kommt man zu interessanten Ergebnissen. Raten an Reglern bringt dagegen wahrscheinlich nichts Neues ein. Heute hat im Prinzip jeder Zugriff auf DSP, das Thema ist mehr als 20 Jahre nach seiner rasanten Entwicklung banal geworden. Viele bleiben beim Bekannten und Einfachen stehen. Das bedingen auch wirtschaftliche Interessen, diese fordern simple Anwendungen, die jeder verstehen und bedienen können soll. Dabei ist es ein Verkaufsvorteil, wenn man sich am schon Vorhandenen orientiert. Dies verhindert potentielle Verbesserungen. Analoge Mischpulte sind notwendig etwas unübersichtlich, ein digitales Werkzeug kann diesen Mangel beheben. Die sklavische Nachahmung des Vorhandenen aber - bis hin zur photorealistischen Reproduktion - gibt keine Freiheit dazu. Ein Produkt muß für die Werbung viel können, aber nicht unbedingt richtig - Hauptsache Klickibunti. Für den Tonkünstler kommt es aber darauf an, gegen den Strom zu schwimmen, sonst landet man im Mainstream. Diese Anstrengung erfordert weiterhin Phantasie und besondere Produktionsmittel.

Quellen [1] De Forest: US-Patent 841,387, Device for Amplifying Feeble Electrical

Currents, 1907

↑Wie alte Musik zu interpretieren sei, wird an vielen Instituten auf der Welt gelehrt. Der Aufwand für diese Lehrveranstaltungen übertrifft denjenigen für neue Musik um einiges. Dabei ist es reine Vermutung, wie es geklungen haben mag. Selbst wenn dies mit Gewissheit feststünde, so ist die Zielgruppe dieser Musik seit etwa 400 Jahren tot. Die Musik richtete sich an eine kleine Elite, mit der der Komponist ein bestimmtes Weltbild teilte. Die Kommunikationssituation zwischen Musiker und Publikum hat sich seitdem tiefgreifend verändert. Sie ist zur Einbahnstraße geworden. Wer auch nur einmal Musik des 20. Jahrhunderts bewusst gehört hat, der hat ein anderes Verhältnis zur "Dissonanz" als vorher. Das ewige Kunstwerk ist eine Illusion aus dem Zeitalter der Romantik. Vorher wurde bedenkenlos neu interpretiert und geändert. Die Musiker mögen lernen, wie damals zu agieren, sich sogar zu kostümieren und den Takt wie einst mit dem großen Stab laut hörbar zu stampfen - worauf man heute doch wohl lieber verzichtet. An das, was einmal war zu erinnern, ist nicht möglich, da das heutige Publikum keine Erinnerung daran haben kann. Es bleibt nur der strukturelle Gehalt der Komposition selbst. Um wenigstens etwas über den Abgrund der Zeit herüberzuholen ist daher aussichtsreicher die Methode einer bewusst von der Historie abweichenden Interpretation. Der Durchschnittsmensch benutzt "klassische Musik" eben nicht als Referenz gegenüber anderer Musik. Die Masse hat keinen Kontakt mehr zur Musik. Es spricht alles dafür, dass es früher nicht viel anders war, eben in der Form der Leierkastenmänner, Kasper, Seppel und Moritaten. Nur hielten sich Kasper und Seppel damals nicht für Weltstars. Weißes Rauschen enthält laut Handbuch alle Frequenzen gleich stark. Das Experiment zeigt, dass zeitweise bestimmte Frequenzen fehlen und von einer Gleichmäßigkeit keine Rede sein kann. Zu den Segnungen des Internets gehört Wikipedia, die freie Enzyklopädie. Bisher wurde so etwas von einem Verlag herausgegeben, mit einem Komitee von Sachberatern und Experten, die wiederum über persönliche Beziehungen Informationen von anderen Beratern einbeziehen konnten. Das ist langsam, auch nicht immer optimal und schwierig zu aktualisieren. Das Lexikon hinkt immer um Jahre hinter der Realität hinterher. Der Text wurde aber in fast allen Fällen mit großer Sorgfalt und Sachkenntnis erstellt, das war der Vorteil. Grobe Fehler waren selten, das stellte das Netzwerk der untereinander bekannten Personen sicher. Es gibt Ausnahmen. So wurde für lange Zeit etwa im Musikbrockhaus unter Fourier-Transformation die Struktur eines Kristalls dargestellt. Es ist sicher richtig, dass die Fourier-Transformation auch in der Kristallographie eine Rolle spielt, wie auch in fast jedem anderen Gebiet der Physik. Der Zusammenhang mit Musik und Akustik ist jedoch äußerst lose, der Leser bleibt hier genauso ratlos wie das Komitee. In Wikipedia kann nun jeder alles eintragen. Problematisch sind diejenigen Bereiche, von denen viele etwas zu wissen glauben, denn dort erfolgt der Umschlag ins Negative. Sich gegenüber stehen perfekte Aufnahmen und von Pannen geplagter Musikeralltag. Die Fotographie hat die realistische Darstellung auf dem Gewissen, die CD die Orchester und Virtuosen. Thomas Mann erzählt nicht in seinen Hauptwerken einfach Geschichten. Der Erzähler interessiert sich nicht einmal für die Protagonisten. Es geht immer um den Zerfall der individualkapitalisch-bürgerlichen Welt in allen Aspekten, bei den Buddenbrooks, auf dem Zauberberg und beim finalen Untergang im Doktor Faustus. Die Musik kommt dabei zwangsläufig auch vor, aber eben nur auch und oft mit der Einschränkung des Dunklen. Der Autor ließ sich dabei von Musikern beraten. Die Romane müssen als Hintergrund für das Nachdenken über Musik herhalten. Warum liest und hört man nicht direkt bei den beratenden Musikern, also vor allen bei Adorno und Schönberg? Einer sprach einmal von der Gefahr, wenn man unbedacht das Radio andreht. Auch abseits des Massenstumpfsinns herrscht Musikbetrieb. Es geht einmal um eine Schlagersängerin, die nach vielen Schwierigkeiten ihr Leben neu geordnet habe und nun ihre neue CD ganz allein mache und vermarkte. Wie naiv muss man sein, um zu glauben, dass im Bereich der Tonträgerindustrie irgend etwas ohne Agenten, Manager, Marketing, kurz: die ganzen dort herrschenden ökonomischen Strukturen ginge? Ein anderer Beitrag handelt von einer Geigerin, die selbstverständlich nur barfuss auftrete, da nur dies ihre spezielle Interpretation ermögliche, ja quasi lebensnotwendig sei. Radiosprecher lesen heute wohl nur noch das Material der Industrieagenturen für Öffentlichkeitsarbeit und Werbung ab. Man erfährt so allerhand, nur nichts über die Musik. Soziale und ökonomische Erscheinungen in und um die Musik werden nicht diskutiert, obwohl ihr Einfluss keineswegs ein geringer ist. Es fehlt vor allem die freie Diskussion der Fachleute. Der Einzelne vollzieht an sich auch in der Musik die Geschichte der Menschheit nach. Vom Nachplappern einfacher Motive über Kinderlieder geht es immer weiter zu Komplizierterem. Die überwiegende Mehrheit blieb und bleibt freilich bei den Kinderliedern stehen. Es ist die Frage, ob das Angebot sich nach der Mehrheit richtet, oder umgekehrt. Es sprach einer von der Kulturindustrie, die mit ihrer Massenware primitive Bedürfnisse befriedige und wahre Musik immer unmöglicher mache. Kritiker hielten dem entgegen, dass die Vorstellung eines totalitären Industriemolochs, der erst Nachfrage wecke, um dann das Geld einzustreichen, absurd sei. Dabei zeugt doch diese Entgegenhaltung selbst von mangelndem Realismus. Der Kenner des Musikbetriebes behauptete niemals ein solches, gewiss auf die Dauer unmögliches System. Denn der Geschmack des Publikums variiert zwar begrenzt, aber unvorhersehbar. Viel Geld wird daher von der Kulturindustrie nur dafür aufgewendet, den jeweiligen Trend rechtzeitig in Erfahrung zu bringen, vor der Konkurrenz. Die Fanatiker sind aufgebracht, wenn man ihnen darlegt, dass auch das vermeintliche Neue dieser Produktionen stets ein Altes ist, von der E-Musik schon vor Jahrzehnten erprobt und nun für die Massenwirksamkeit zurechtgestutzt, verdünnt und wieder aufgewärmt. Inzwischen sind vierzig Jahre vergangen. Heute kann jeder, der auch nur ansatzweise das Metier beherrscht durch hinreichende Wiederholung in den Medien bis in die Top-40 gebracht werden. Die Beeinflussung der Medien wurde schon früh mit großer Offenheit als "plugging" (engl.: hineinstopfen, auch Schleichwerbung) bezeichnet. Es bestehen nicht nur phonetisch Bezüge zur Agrotechnik. Ist genügend gepflügt und die Saat ausgebracht, so wird die lohnende Ernte nicht lange auf sich warten lassen und man wird dabei mit allen Mitteln nachhelfen. Ob der Erfolg überragend wird, lässt sich freilich nicht sicher vorhersagen, er hängt eben auch vom Wetter ab. Zum Glück ist das Mozart-Jahr nun vorüber. Alles mögliche habe ich über W. A. Mozart erfahren. Es wäre dabei interessant gewesen, die ewige Unfreiheit des Wolfgang Amadé zu betrachten, als Angestellter seines Vaters in der Mozart GmbH und Co. KG, als Lakai des Kirchenfürsten zu Salzburg und als von Schulden geplagter und nach Anstellungen suchender, wirtschaftlich erfolgloser Komponist. Über die Musik wurde fast nicht gesprochen. Man kann den Standpunkt vertreten, dass überhaupt nur die Musik gespielt werden sollte. Wenn man nun aber schon Textbeiträge für nötig hält, so sollten sich diese auch mit dem Werk beschäftigen und nicht mit Begleitumständen. Es besteht dabei wohl eine Schwierigkeit: kein Spätwerk, wenn man nur 36 Jahre lebt. Was hätte Mozart wohl als von wirtschaftlichen Zwängen Befreiter komponiert? Die Kaserne bildet für den Schützengraben aus, die Musikhochschule für den Orchestergraben. Es ist mir kein im Alltag relevantes Gebiet der Technik bekannt, dass ein derart unvorteilhaftes Wissensgefälle zwischen Verbrauchern und Herstellern aufweist, wie wir es bei elektroakustischen Wiedergabeeinrichtungen vorfinden. Verstärker, Mischpulte, CD- und DAT-Abspielgeräte usw. können, wenn sie nach den Regeln der Kunst erstellt wurden, heute praktisch als fehlerfrei gelten, vor allem wenn man die möglichen Probleme auf dieser Seite mit den tatsächlichen Problemen von Lautsprechern vergleicht. Beim Kauf eines Automobils interessiert sich jeder Kunde selbstverständlich für den Wendekreis, den Verbrauch, das Volumen des Kofferraums, die Beschleunigung, die Spitzengeschwindigkeit und viele andere Messwerte mehr, die entweder selbsterklärend sind oder nach bestimmten Normen angegeben werden. Wehe dem Hersteller, dem bei diesen Angaben ein Fehler unterläuft. Dass ein Trabant die Fahrleistungen auch nur des schwächsten Porsche-Modells erreichen kann, würde keiner auch nur einen Moment glauben. Bei Lautsprechern hingegen kommt man mit Versprechungen solcher Art durch. Nur in einigen Fällen bekommt der Verbraucher überhaupt Messwerte zu sehen. Die Messbedingungen werden oft absichtlich so gewählt, dass die Vergleichbarkeit erschwert wird. Das ist noch die geringste Schwierigkeit. Nur zu oft sind die Werte reine Fantasie. Dabei wäre ein genormter Lautsprechertest weder schwierig noch unzumutbar für die Hersteller. Mit einem solchen Datenblatt in der Hand könnte man sich die meisten Hörtests sparen und für die geplante Anwendung ungeeignete Lautsprecher von vorne herein aussortieren. Aber die Wirklichkeit ist anders. Ein Foto, Angaben zu Größe und Gewicht sowie dem "Übertragungsbereich" und schließlich der Preis, dies ist alles. Wenn zusätzliche Informationen erhältlich sind, dann meist nicht in Form eines Datenblattes, sondern als bunte Hochglanzbroschüren mit Propagandacharakter und irrelevanten Zahlen. Wer Lautsprecher nach kg und Farbe kauft, muss sich nicht wundern, wenn der Klang bescheiden ist. Wenn man die Eigenschaften des Abhörraumes hinzuzieht, so werden die entscheidenden Fehler, die eindeutig dem Lautsprecher selbst zuzuordnen sind, deutlich: die eingeschränkte Dynamik, die mangelhafte Wiedergabe tiefer Töne sowie zu starke Intermodulations-produkte. Das Klirren geht meist einher mit mangelndem Wirkungsgrad, zu kleine Membranen müssen zu große Auslenkungen machen und erzeugen durch zu schwache Antriebe dabei zu viel Hitze. In Wahrheit hat sich bei Dynamik und Klirr seit 30 Jahren nichts verbessert. Verstärker können mit geringen Klirrfaktoren aufwarten, viele Lautsprecher klirren dagegen schon bei mittlerem Pegel. Sie können deshalb nicht das abbilden, was im Parkett, und noch weniger, was mitten im Sinfonieorchester oder an der Orgel klar zu hören ist. Eine Veröffentlichung der vorher genannten Daten würde diesen Stillstand auf niedrigem Niveau transparent machen und den Verbraucher verunsichern. Man beschränkt sich in der Branche daher auf kosmetische Eingriffe. Die kosten wenig und bringen nichts. Oder man setzt auf sinkende Preise bei schlechterer Funktion. Hauptsache die Gewinnspanne bleibt. Unseriöse Hersteller stecken schon seit langem mehr Geld in Propaganda, als in die Entwicklung. Da werden schuhkartongroße Klangwunder mit teuren Anzeigen beworben, es gibt ständig neue Wunderprinzipien, Wunderkabel, Wunderständer, alles zu Phantasiepreisen. Aber die Physik ist weiterhin böse. Gute Lautsprecher sind groß, schwer und inkompatibel mit der Innenarchitektur, die Farbe ist allerdings beliebig. Die Musik ist selbst nicht fähig zur Erkenntnis ihrer Fundamente. Der Fragende und Forschende macht sich da schnell unbeliebt. Abweichler werden in der Wissenschaft mit Spott und Hohn bedacht, gelegentlich aber durchaus mit Hass. Neuerungen, an denen etwas dran ist, setzen sich durch, einfach weil die Alten sterben. Nicht so in der Musik. Bölsche warf Eimert aus dem Musikkonservatorium hinaus, der Grund war ein Zwölftonstreichquartett nebst der dazugehörigen "Atonalen Musiklehre". Jens Jensen schrieb in der Zeit: "die Geisteswissenschaftler geben den sprachlosen Naturwissenschaften eine Sprache ...". Galileo Galilei schrieb: "Die Natur spricht die Sprache der Mathematik: die Buchstaben dieser Sprache sind Dreiecke, Kreise und andere mathematische Figuren". In der Mathematik hat man die exakteste Sprache gefunden, die sich nur denken lässt, heute mehr algebraisch als geometrisch. Herr Jensen hätte - sicher für ihn selbst völlig unerwartet - Recht, wenn nur die Mathematik den Geisteswissenschaften zuzurechnen wäre. In der Musik ist oft die Rede von der Logik. Bei näherem Hinsehen handelt es sich dabei stets um Vereinbarungen, Satzungen oder gar unbewusste Gewohnheiten. In der Musik ist nie die Rede von Soziologie oder Ökonomie. Denn es sind dies gewichtige Faktoren der musikalischen Produktion. Ein Mathematiker bemerkte neulich, dass der Stand des mathematischen Wissens der breiten Öffentlichkeit sich etwa auf dem Niveau der Antike bewege. Eigentlich lasse sich das Gewusste sowieso nur unter dem Namen Rechnen zusammenfassen und habe mit Mathematik rein gar nichts zu tun. Oft ist vom musikalischen Einfall die Rede, von der Inspiration. Der Komponist Hindemith hat mit seinen Schülern dazu experimentiert. Es sollten spontane Ideen notiert werden. Durch gegenseitige Kritik kam schnell heraus, dass nach Abzug aller Ausarbeitung nur eine Handvoll Töne als originärer Einfall übrig blieb. So kann man immer noch von 1 % Inspiration und 99 % Transpiration sprechen. Die Musik ist auf einer Fahrt weg von der Masse der Hörer. Die amtliche Legende beginnt mit Wagners "Tristan". Fachleute schüttelten nur den Kopf. Die Musiker waren selbst nach der zwanzigsten Probe nicht zu einer Aufführung in der Lage. Erst die finanzielle Hilfe durch Ludwig II machte diese sehr verspätet überhaupt möglich. Heute ist die harmonische Kühnheit dieses Werkes kaum noch nachzuvollziehen. Weiter geht es mit Strawinskis "Sacre du Printemps", einem geplanten Uraufführungsskandal, bei dem es sogar zu Tätlichkeiten zwischen Gegnern und Befürwortern gekommen sein soll. Das Kalkül des Impressarios Diaghilev verstand der junge Strawinsky damals noch nicht. Ein Skandal war der Sache noch nie abträglich. Das nie ganz fertiggestellte "Tuning up" von Varèse mokiert sich über die Hörer, die beim Einsetzen etwas modernerer Musik glauben, es würden immer noch die Instrumente gestimmt. Die Musiker tun dies in diesem Werk fast die ganze Zeit, neben der Schlagzeugbatterie und den unvermeidbaren Sirenen. Man kann das weiter verfolgen, bis zu Ligetis frühen Orchesterwerken und Stockhausens "Helikopter Quartet". Es wird schon wieder werden mit der Publikumsgunst. Dies wohlmeinende Hoffen tut der Musik nicht Gutes. Es kann eben nicht werden, wenn die Musik irgend etwas Wahres über den Zustand dieser Welt sagt. Der Komponist Lachenmann meint, dass es keine weißen Flecken auf der Landkarte der Klänge mehr gäbe. Was ist aber Klang und wie ist er zu kartieren? Dafür gibt es noch nicht einmal den Ansatz einer Theorie, insofern ist die These ziemlich mutig. Lachenmann hat sich wohl nie mit Elektronischer Musik auseinandergesetzt. Die graphischen Benutzeroberflächen mit Fenstern, Menüs und Maus stammen aus Forschungen am "Xerox Palo Alto Research Center" um 1970. Inzwischen dominieren sie die Mensch-Rechner Interaktion so weit, dass manche gar nichts anderes mehr kennen. Programmierer müssen graphische Elemente deshalb auch dann anbieten, wenn es keinen Sinn macht. Die Maussteuerung ist hilfreich, wenn es um die seltene, einfache, geometrisch ungenaue Interaktion von nur wenigen Objekten geht, zum Beispiel um das Löschen einer bestimmten Datei. Professionelle Anwendungen erzeugen oder benötigen aber oft Hunderte oder Tausende von Dateien. Es ist auch nicht immer klar, wie diese heißen und wo sie sich befinden. Es sind sehr oft wiederholt und in Abhängigkeit von Ergebnissen seine ganze Reihe von Aktionen notwendig. Einen Regler um nur wenige Grad zu drehen, wird mit der Maus zum Geduldsspiel. Für solche Aufgaben ist die Tastatur mit Konsole viel besser geeignet. Es gibt zahlreiche Programme, die damit Befehle entgegennehmen können, die Symbole und Abkürzungen auf tatsächlich vorhandene Dateinamen expandieren und die ganze Folgen solcher Befehle in kleinen Programmen ablaufen lassen. Hieraus haben sich spezielle Interpretersprachen wie z. B. "Perl" entwickelt. Sie helfen bei der automatischen Verwaltung und Prozessierung von Daten. Statt dessen wird weiterhin herumgeklickt, bis die Finger schmerzen. Er habe keine Ahnung von der Elektroakustik. Dies erklärte mit abwertendem Tonfall ein Komponist neulich in einem Bildungsblattinterview. Einmal versuchte er es aber dann doch mit Lautsprechern. Es klang furchtbar. Stockhausen hat einmal die Wellenformen des "EMS Synthi 100" als langweilig bezeichnet. Mehr oder weniger regelmäßige Oszillationen und mit ihnen eine große Klasse von elektronischen Instrumenten werden damit abgetan. Wer nur einmal hörte, was Stockhausen schon 1956 klanglich aus der Tonbandverarbeitung herausdestillieren konnte, wird diese Einschätzung teilen. Es wird oft gesagt, Elektronische Musik basiere auf plakativen Effekten. Was aber anderes ist der juchzende Bogenstrich, die rasende Kadenz auf der Tastatur, die große Geste in der althergebrachten Musik? Die schlimmsten Störungen in Konzerten sind Mobiltelefone und das Husten. Während der GSM-Empfang schon durch einen kleinen Störsender zuverlässig unterdrückt werden kann, ist dies mit der Husterei nicht möglich. Ein Dirigent sah sich kürzlich sogar genötigt, die Darbietung abzubrechen. Dilletanten auf dem Gebiet des Konzerthustens räuspern sich nur, oder verausgaben sich schon beim ersten Stück, so dass sie weiterhin nur noch zu leisem Röcheln fähig sind. Der professionelle Huster arbeitet dagegen stets an seiner maximalen Penetranz und Ausdauer. Er kennt jede Pianissimostelle auswendig, in die zu husten sich lohnt. Manch einer hat schon unter allen berühmten Dirigenten gehustet. Ein anderes Phänomen ist das programmatische Husten. Es war ein Konzertabend mit Tschaikowsky und Schönberg, Hustenbonbons wurden überall kostenlos gereicht. Bei der Musik des als "Kunsthandwerker" geschmähten war es auch dementsprechend ruhig, bei Schönbergs "Verklärter Nacht" dauerte es aber nicht lange, bis die Nebengeräusche zur Höchstform aufliefen. Beim Ausklang mit "Kunsthandwerk" war es wieder ruhig. Das erlaubt nicht die Erklärung, dass mit steigender Dauer des Stillsitzens der Hustenreiz schlimmer werde. Dass die Vorräte an Hustenbonbons etwa aufgebraucht waren, kommt auch nicht in Frage. Obwohl "Verklärte Nacht" von 1899 sicher nicht die revolutionärste Komposition Schönbergs ist, so kündigt sie das Kommende bereits an. Der brave Bürger reagiert seit je verstört darauf, den Zustand der Welt in der Musik wiederzuerkennen. Die lineare Systemtheorie kann große Erfolge verbuchen. Ermöglicht werden diese auch durch die Laplace- bzw. Fouriertransformation. Nachteilig ist dabei die fehlende Lokalisation der Basisfunktionen. Sinus und Kosinus sind zeitlich unendlich ausgedehnte Funktionen. Für statische oder langsam modulierte Wellenformen, wie wir sie bei Radiowellen vorfinden, ist dies kein Problem. Es ist ohnehin unproblematisch, wenn man Hin- und Rücktransformation nur zur Rechenzeitersparnis anwendet. Audiosignale sind jedoch schnell moduliert, Träger und Modulator liegen in überlappenden Frequenzbereichen. Im besten Fall sagen uns die genannten Transformationen dann nur, welche Frequenzkomponenten in einem solchen Signal enthalten waren. Aber sie sagen uns nicht wann. Die Mathematik hat daher um 1980 die Wavelet-Transformation hervorgebracht, die sowohl Frequenz- als auch Zeitauflösung bietet. Weiterhin gilt die Unschärferelation: gesteigerte Frequenzauflösung geht immer zu Lasten der Zeitauflösung und umgekehrt. Die Wavelet-Transformation erlaubt hierbei den günstigsten Kompromiss zu wählen. Dessen ungeachtet fährt man unbekümmert weiter fort, Audio-Signale mit ungeeigneten Transformationen zu analysieren. Man wundert sich nur gelegentlich über die schlechten Ergebnisse und passt dann Modelle mit Gewalt an den ungünstigen Befund an. 20 Jahre Verzögerung zwischen mathematischer Forschung und Eingang in die Praxis ist aber eher noch ein guter Wert. Shannon, Kotelnikov, Whittaker, Nyquist, Rabe und sicher noch weitere haben in den 20er und 30er Jahren des letzten Jahrhunderts unabhängig voneinander das Abtasttheorem bewiesen. Der Beweis liegt nicht tief. Demnach ist jede veränderliche Größe durch genügend häufiges Abtasten repräsentierbar. Dies gilt auch für Audiosignale. Die entstehende Zahlenfolge zusammen mit der Angabe der Abtastrate enthält die komplette Information. Ein eher praktischer Gesichtspunkt ist, dass eine Rasterung der Abtastwerte schon in einige hunderttausend Stufen ausreichend ist. Damit reduziert sich die Aufgabenstellung der Elektronischen Musik auf die Bereitung von sehr langen Folgen aus ganzen Zahlen. Dies klingt einfach und erweist sich doch als äußerst schwierig. Eine Sekunde Audio mono bietet rechnerisch sehr viele verschiedene Folgen. Für ihre Zahl gibt es keinen Namen, sie ist größer als eine 1 mit 176.000 Nullen dahinter. Es gibt keine Theorie, die interessant klingende Folgen von uninteressanten unterscheiden könnte. Sehr viele voneinander verschiedene Folgen klingen ununterscheidbar gleich, das ist sicher. Die für die Musik bedeutendste Erfindung des 20. Jahrhunderts ist das Magnetophon. Nichts weniger als Zeit und Kausalität sind damit aufgehoben. Es ist oft die Rede von der "klassischen Musik" oder schlicht und schlimmer von "Klassik". Kaufleute brauchen eine Schublade, in die sie die Ware einordnen können. So entsteht der Begriff im Branchenjargon. Dieser umfasst die gesamte abendländische Kunstmusik, also die sogenannte "ernste Musik". Bach, Beethoven oder Bartok, das ist für Krämer alles einerlei. Da den meisten Hörern die alte und die neue Musik und zunehmend die gesamte ernste Musik überhaupt unbekannt ist, kommt es auf eine Unterscheidung auch gar nicht mehr an. Kulturprogramme im Radio bedienen sich dieser Ausdrucksweise schon lange. Es ist der sozialen Sachlage entsprechend. Die enge Verbindung dieser Anstalten zum Marketing wirkt auch in der Sprache sich aus. Die klassische Musik im eigentlichen Sinn wird aber immer noch von den drei Sonnen Haydn, Mozart und Beethoven gebildet, mit ihrem Planentenschwarm von Meistern. Ob der Stern Schubert noch zu diesem Gravitationssystem gehört, ist bereits strittig. Die berühmte "kopernikanische Wende" hat es nie gegeben. Den Druck von "De revolutionibus orbium coelestium" hielt Nikolas Koppernigk erst auf dem Totenbett in Händen, versehen mit einem entstellenden Vorwort aus fremder Feder. Das Werk wurde zu seiner Zeit völlig ignoriert. Denn die Annahme von Kreisbahnen um die Sonne war weder mit den Beobachtungsdaten vereinbar noch neu. Schon bei Aristarchos im dritten Jahrhundert v. Chr. lässt sich so ein Modell finden. Gegenüber der Lehre des Ptolemäus war auch kein Fortschritt in der Erklärung der Bewegungen zu verzeichnen. Kepplers Ellipsen passten zwar besser zu den Daten, aber niemand wusste warum. Die Vorbehalte der Kirche waren also nicht allesamt unsinnig. Erst Newton konnte mit seiner Mechanik eine geschlossene wissenschaftliche Theorie anbieten, die die Kepplerbahnen halbwegs erklärt. Das Sonnensystem besteht aber aus mehr als zwei Körpern. Poincaré fand 1912 heraus, dass so ein dynamisches System deterministisch chaotisch ist. Die Bahnberechnung über viele Millionen Jahre hinweg wird damit unmöglich. Die Bahnen sind nicht geschlossene Kurven und damit keine elementare geometrische Figuren. Selbst bei einem reinen Zweikörpersystem ähneln nach Einstein die Bahnen Spiralen, bis zum Absturz. Die Möglichkeit, dass Noten manche Musik beschreiben können, ist bereits das Resultat einer Beschränkung. Manche halten die Elektronische Musik für ein seit langem gescheitertes Vorhaben. Das Ziel der freien Klangestaltung ist bis heute nur unzureichend umgesetzt worden. Es gibt, fast paradox, als spiritus loci den typischen Klang der großen Studios, genau wie den spezifischen Klang der bisherigen Verfahrensweisen. Fest steht aber, dass viele Komponisten, die auch nur ein einziges Stück im elektronischen Studio realisierten, von dieser Erfahrung tief beeindruckt wurden. Der Musiker ist danach nicht mehr derselbe. Denn er musste wieder bei Null anfangen. Die bisherigen musikalischen Satzungen und die Beschränkungen der mechanischen Musikinstrumente entfallen. Die dadurch mögliche, tiefe Erkenntnis über das Wesen der Klänge und des Gehörs werden in keiner Kompositionsklasse vermittelt. Das musikalische Denken hat sich dadurch verändert. Ein guter Teil der Instrumental- und Vokalmusik nach 1953 zeigt deutliche Einflüsse dieser Erfahrungen. Schon allein deshalb war die Elektronische Musik nicht vergebens. Stephen Reich äußerte sich unlängst in einem Interview über Arnold Schönberg. Dessen Musik sei überintellektualisiert, vor allem die späteren Kompositionen in der Zwölftontechnik. Er unterstellte dabei außermusikalische Motive, die Neuerung um der Neuerung willen und Ruhmsucht. Folglich werde diese Musik bald niemand mehr hören wollen. Diese Art der Kritik ist uns seit langem bekannt und zwar aus der völkischen Ecke. Man hätte nicht erwartet, gerade solche Äußerungen nun von Reich zu hören. Reichs "minimal music" ist ununterscheidbar nahe an die Popmusik gerückt und damit zweifellos massenkompatibler. Schönbergs Musik wird immer noch kontrovers diskutiert werden, wenn Reich längst vergessen ist. Wenn man eine große Zahl von Werken der Elektronischen Musik kennt, so ist eine Stagnation unüberhörbar. Die bisher geübten Verfahren ergeben eben nur eine bestimmte Art und Anzahl von unterscheidbaren Klängen. So müssen sich Klangstrukturen zwangsläufig irgendwann wiederholen. Haben wir nun den Zustand der Neuen Musik ereicht? Die Instrumentalisten mühen sich seit mehr als 40 Jahren, die vom Komponisten geforderten, immer gleichen Quietsch-, Brumm-, Quäk-, Klapp- und Rauschklänge aus ihren mechanischen Instrumenten herauszuholen. Der logische Abschluss dieser Versuche ist die Zerstörung der Instrumente vor Publikum, auch dies erzeugt Geräusche. Man möchte dem Komponisten und Philosophen Adorno zustimmen, wenn er das Ende jeglicher Musik konstatiert, die Unmöglichkeit Neues zu erzeugen. Während die herkömmliche Instrumental- und Vokalmusik in einer Endlosschleife von Festival zu Festival rotiert, so besteht aber in der Elektronischen Musik wenigstens noch die Möglichkeit zur Neuerung. Dabei wird man vom Menschen ausgehen müssen, oder genauer: von den potenziellen Möglichkeiten seines Gehörsinns. In Science-Fiction Filmen finden wir eine merkwürdige Mischung. Durch das Vakuum des interstellaren Raumes dringen Schallwellen zu uns, elektronische Effekte markieren Antriebsgeräusche und Laserwaffen. Diese Unmöglichkeit nimmt der Zuschauer nicht wahr, ebenso die Tatsache, dass es da draußen immer noch ein Oben und ein Unten gibt und die Akteure keinerlei Schwierigkeiten mit der Fortbewegung in der Schwerelosigkeit haben. Die primitiven elektronischen Effekte setzen sich im Unterbewusstsein fest, zum Schaden der Elektronischen Musik, die so unverschuldet in die Nähe des Banalen gerückt wird. Dazu gibt es Filmmusik mit mechanischen Instrumenten nach romantischer Manier oder es wird einfach nur bei Wagner oder Strawinski kopiert. Die Spezialeffekte hätte man, es fehlt nur ein anständiges Drehbuch. Es gibt Ausnahmen. In "Forbidden Planet" von 1956 ist die Filmmusik durch und durch experimentell elektronisch. Das Ehepaar Louis und Bebe Barron kreierte einen nichttrivialen Soundtrack. Es gibt Ähnlichkeiten mit den ersten freien elektronischen Stücken von Herbert Eimert und Robert Beyer. Die Musikergewerkschaft setzte durch, dass das Ergebnis nicht als Musik bezeichnet werden durfte, sondern als "Electronic Tonalities". Ein Oscar kam dann nicht mehr in Frage. Das Drehbuch ist nicht schlecht, denn es ist bei Shakespeares "Der Sturm" abgekupfert. Stanley Kubrick ging mit "2001: A Space Odyssey" einen anderen Weg. Ohne Erlaubnis des Komponisten benutzte man Ligetis "Requiem", "Atmospheres", "Lux Aeterna" und "Aventures", also zeitgenössische ernste Musik, als Kontrast dazu Richard Strauß "Also sprach Zarathustra", und Johann Strauß "An der schönen blauen Donau". Die Akteure kämpfen u. a. mit der Schwerelosigkeit und der Weltraum selbst ist völlig still. So etwas war wohl nur in England, abseits der US-Studio-Moguln möglich. Die Ergebnisse der Naturwissenschaften sind nicht wahr, denn sie lassen sich nur widerlegen, nicht beweisen. Die Ergebnisse der Mathematik sind war, aber Tautologien. Die Geisteswissenschaftler schreiben wiederum verfälschend das ab, was andere schon falsch aufgeschrieben haben. Und Musik kennt keinen Begriff, ist also zu einer Aussage nicht fähig. Der Sinuston ist laut Handbuch das Atom der Musik. Dies ist aber kein Satz der Mathematik oder Physik, sondern nur ein Modell der Physiologie des Innenohres. Im Experiment lassen sich Geräusche nicht in Sinustöne zerlegen. Sie hören nun ein Konzert mit dem bekannten Interpreten X unter der Stabführung des berühmten Dirigenten Y. Es spielen die überragenden Z Sinfoniker. Wenn alles so bekannt, berühmt und überragend ist, wieso fühlt sich der Ansager im Radio genötigt, dies stets zu betonen?

Rückseite

|

|

© ZeM e.V. | ZeM Heft Nr. 27 - 2006

|